Twitterによる制限

2023/6/30 TwitterによるAPI制限や非ログイン閲覧制限されたため、nitterでのTwitter記事取得等が出来なくなりました

下記、DockerによるNitter構築は可能ですが、Twitter側の制限が解除されない限り使い物になりません

XDA Developers forum "403 Forbidden"

自宅のローカル内では、問題なく接続が可能です

## 原因調査

自宅内のLANでは問題なく接続できて、外部から接続出来ないとなると、WANルーターを疑うのが妥当だと思います

ちなみに、我が家のルーターはPR-400KIを使用しています

問題解決にあたり、ルーターを再起動してみると、外部からアクセス出来る事が確認できたため、ポート開放設定に問題があるわけではなさそうです

問題が発生した際に、毎回ルーターを再起動するのも得策ではありませんし、自宅外では作業ができません

更に、ルーター内の機能を調べていくと、ルーターの再起動を行わなくても、`UPnP NAT情報消去`の機能により改善することが判明しました

## 解決策

原因調査の結果、UPnP NAT情報が原因で接続出来ないようですので、ルーター内の設定(**詳細設定>高度な設定>UPnP設定**)で`UPnPを使用しない`へ設定したところ、これ以降、Forbiddenで外部から接続出来ない問題は発生しなくなりました。

私の環境のように自宅内にサーバーを構築して、外部とのやりとりを行うのでなければ、UPnPはゲームやAppleTV,IoTのホームデバイスで簡単に接続を利用できる機能なので、通常は使用した方が良いかと思います。

UPnPについては、下記の記事を参考にさせていただきました

--------------------------------------------------------------------------------

title: "msmtpでGmailのSMTPでメール送信"

date: "2021-05-13"

url: https://scribble.washo3.com/msmtp-gmail/

--------------------------------------------------------------------------------

Debian10にmsmtpインストールし、GmailのSMTPサーバーでメール送信したい

## msmtp

メールを送信するだけのホストではsSMTPをよく使っていましたが、Debian10ではssmtpのパッケージが存在しません。

替わりになるものがmsmtp

## msmtpのインストール

```

# apt install msmtp msmtp-mta

```

## 設定

設定ファイルが/etcにないので、サンプルをコピー

```

# cp /usr/share/doc/msmtp/examples/msmtprc-system.example /etc/msmtprc

```

ちなみに、ユーザー単位の場合は

```

# cp /usr/share/doc/msmtp/examples/msmtprc-user.example ~/.msmtprc

```

### 設定ファイルを編集

```bash

# Set default values for all following accounts.

defaults

auth on

tls on

tls_trust_file /etc/ssl/certs/ca-certificates.crt

# gmail service

account gmail

host smtp.gmail.com

port 587

from user@gmail.com

user user@gmail.com

password ******

# Set a default account

account default : gmail

```

### 送信テスト

```bash

$ echo "hello world." | msmtp user@gmail.com

msmtp: account default not found: no configuration file available

```

設定ファイルに問題はないので、この場合は、パーミッションの問題

```bash

# chown root:msmtp /etc/msmtprc

# chmod 640 /etc/msmtprc

```

この他に、下記のエラーが出る場合は、msmtprc内のhost欄をIPで設定

```bash

msmtp: account default from /etc/msmtprc: host not set

```

再度、送信してみると、gmailの送信エラー

```bash

$ echo "hello world." | msmtp user@gmail.com

msmtp: authentication failed (method PLAIN)

msmtp: server message: 534-5.7.9 Application-specific password required. Learn more at

msmtp: server message: 534 5.7.9 https://support.google.com/mail/?p=InvalidSecondFactor c130sm1091555pfc.51 - gsmtp

msmtp: could not send mail (account default from /etc/msmtprc)

```

2段階認証を設定している場合、Googleアカウントへのアクセスにはアプリ専用のパスワードを設定する必要があるとの事(Application-specific password required)

2段階認証に設定していなければ、ここで送信が成功しているはずです。(この場合、下記は不要です)

## アプリパスワード生成

> アプリ パスワードを使用すると、2 段階認証プロセスに対応していないデバイス上のアプリから Google アカウントにログインできるようになります。このパスワードは一度入力すれば、以降は覚えておく必要はありません。

{{< imgur id="5l6udvA" >}}

アプリパスワード欄をクリックし、`デバイス選択`の`その他`で任意の名前を入力

{{< imgur id="No16qB5" >}}

最後に生成を押すと、コードが発行されるので保存(**生成コードはそれぞれ違います**)

```bash

rxgvdegplcmoxxxx

```

このコードをmsmtprcのpasswordに置き換えます

(ユーザーのログインパスワードでなく、このコードがパスワードになる)

これで、送信の際にエラーが出なくて、メールが届けば成功です

--------------------------------------------------------------------------------

title: "Virtualboxが消えた??"

date: "2021-05-12"

url: https://scribble.washo3.com/virtualbox-disapeared/

--------------------------------------------------------------------------------

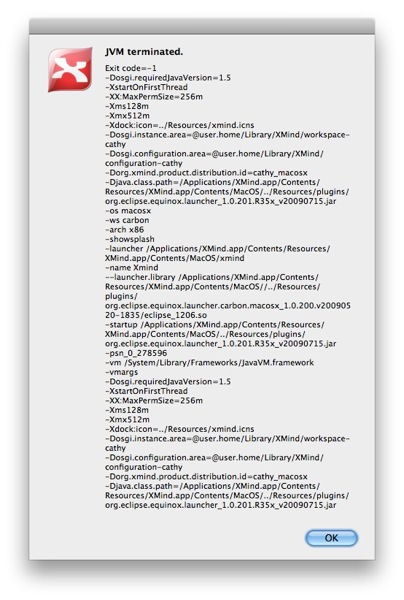

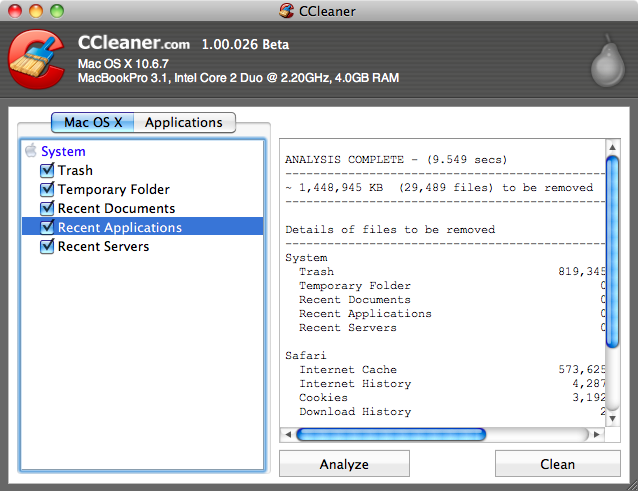

## 不具合症状

Mac上のvagrantで、dockerコンテナでいくつかのサーバを稼働させているのですが、vagrantで起動したゲストOSが起動しなくなり、`vagrant ssh`でも`vagrant halt`も出来なくなった。

```bash

$ vagrant halt

The provider 'virtualbox' that was requested to back the machine

'default' is reporting that it isn't usable on this system. The

reason is shown below:

Vagrant could not detect VirtualBox! Make sure VirtualBox is properly installed.

Vagrant uses the `VBoxManage` binary that ships with VirtualBox, and requires

this to be available on the PATH. If VirtualBox is installed, please find the

`VBoxManage` binary and add it to the PATH environmental variable.

```

virtualboxが見つからない? 消えた?

## Virtualboxが消えた原因

おそらく、定期的にHomebrewで更新をかけたのが原因ではないかと推測。

`brew update;brew upgrade`でVirtualboxに更新があった場合に、アンインストールのスクリプトが実行され、インストールが正常にできなかったので、消失したままなのではないかと。

### virtualboxを再インストールしてみる

```bash

$ brew reinstall virtualbox

...

(kernel) Kext org.virtualbox.kext.VBoxNetFlt did not stop (return code 0x5).

(kernel) Kext org.virtualbox.kext.VBoxNetFlt can't unload - module stop returned 0xdc008017.

Failed to unload org.virtualbox.kext.VBoxNetFlt - (libkern/kext) kext (kmod) start/stop routine failed.

An error occurred durning 'sudo /sbin/kextunload -m org.virtualbox.kext.VBoxNetFlt', there should be a message above. (rc=3)

unloading org.virtualbox.kext.VBoxDrv

(kernel) Can't remove kext org.virtualbox.kext.VBoxDrv; services failed to terminate - 0xdc008018.

Failed to unload org.virtualbox.kext.VBoxDrv - (libkern/kext) kext is in use or retained (cannot unload).

```

再インストールも失敗してますね。

どうやら、VBox関連のプロセスが起動したままなのでインストール出来ないようです。

### VBox関連のプロセスを停止

```bash

$ ps aux|grep VBox

user 1053 4.9 16.9 10433224 5664640 ?? S 27 421 1198:10.06 /Applications/VirtualBox.app/Contents/MacOS/VBoxHeadless --comment vagrant_default_1617775585834_25189 --startvm 92f812c7-e002-4915-a44e-37f956c82adc --vrde config

user 86410 0.2 0.0 4399028 792 s000 R+ 10:36AM 0:00.00 grep VBox

user 925 0.0 0.1 4876816 18988 ?? S 27 421 15:23.36 /Applications/VirtualBox.app/Contents/MacOS/VBoxSVC --auto-shutdown

user 923 0.0 0.0 4427532 11152 ?? S 27 421 2:34.08 /Applications/VirtualBox.app/Contents/MacOS/VBoxXPCOMIPCD

```

VBOX関連のプロセスが起動していたため、再インストールに失敗しているので、VBOX関連のプロセスをkill

上記の場合だと`kill 923 925 1053`

この後、再度、Virtualboxをインストールしたところ、無事インストールが完了し、`vagrant up`で正常に起動した

## 補足

なんだかんだ、Virtualbox+vagrantは不具合に遭う機会が多いように感じます

今後もVirtualboxの更新が入ると、同症状の問題が起きる可能性が高いので、homebrewでvirtualboxを除外しておいた方が無難かもしれませんね。

### 指定したフォーミュラを除外

```

brew pin フォーミュラ名

```

### 除外を解除(元に戻す)

```

brew unpin フォーミュラ名

```

### 除外設定したフォーミュラの一覧表示

```

brew list --pinned

```

--------------------------------------------------------------------------------

title: "HugoでSubmoduleのテーマ更新メモ"

date: "2021-05-11"

url: https://scribble.washo3.com/hugo-submodule-update/

--------------------------------------------------------------------------------

このサイトでは、Gitlab上にてHugoのBeautifulhuigoのテーマをsubmoduleで管理しています。

時々、本家submodueのテーマが更新されますが、gitのcloneやpushでは、submoduleは自動で更新されません

なので、手動で更新してあげる必要があり、よく作業するので、メモっておきます

## 自分のリポジトリをクローン

```bash

$ git clone --recurse-submodules --depth 1 https://gitlab.com/user/repo.git

$ cd repo

```

## submodule更新

実際作業するのは、`git submodule update --remote`だけで良いです

```bash

$ git submodule status

91a30c4f752864aaafa2ae2b633d022c8810a5e8 themes/mainroad (91a30c4)

$ git submodule update --remote

Submodule path 'themes/mainroad': checked out '10d59da42f7bca5e7bd9e0409509a608fdd84080'

$ git diff

diff --git a/themes/mainroad b/themes/mainroad

index 91a30c4..10d59da 160000

--- a/themes/mainroad

+++ b/themes/mainroad

@@ -1 +1 @@

-Subproject commit 91a30c4f752864aaafa2ae2b633d022c8810a5e8

+Subproject commit 10d59da42f7bca5e7bd9e0409509a608fdd84080

```

## 更新したsubmoduleを適用

```bash

$ git status

On branch master

Your branch is up to date with 'origin/master'.

Changes not staged for commit:

(use "git add -

{{ if .Paginator.HasPrev }}

- - ← {{ i18n "newerPosts" }} + ← {{ i18n "newerPosts" }} {{ end }} {{ if .Paginator.HasNext }}

- - {{ i18n "olderPosts" }} → + {{ i18n "olderPosts" }} → {{ end }}

-

{{ if .Paginator.HasPrev }}

- - ← {{ i18n "newerPosts" }} + ← {{ i18n "newerPosts" }} {{ end }} {{ if .Paginator.HasNext }}

- - {{ i18n "olderPosts" }} → + {{ i18n "olderPosts" }} → {{ end }}

| 内容 | 内容 | 内容 | 内容 |

| 内容 | 内容 | ||

| 内容 | 内容 | 内容 | |

| 内容 | |||

long time, so long

that the text does

not fit on a row. Bob-->Alice: Checking with John... Alice->John: Yes... John, how are you? {{< /mermaid >}} ------- * https://mermaidjs.github.io/demos.html * https://mermaidjs.github.io/mermaid-live-editor/ -------------------------------------------------------------------------------- title: "Hugoでの初投稿" date: "2019-05-04" url: https://scribble.washo3.com/fist-commit/ -------------------------------------------------------------------------------- HugoとGitLab、Netlifyを利用し、サイトを構築してみた # サイト構築 ## 前提条件 - GitLabアカウント登録済み - Netlifyアカウント登録済み - ローカルにhugoをインストール済み ### 作業手順 1. GitLabにてリポジトリ作成 2. ローカルにgit clone 3. hugoで新規サイト作成 4. 3.で作成したディレクトリ・ファイルを2.のディレクトリへコピー 5. .gitignore作成 ``` .DS_Store public ``` 6. テーマをインストール ``` $ git submodule add https://github.com/halogenica/beautifulhugo.git beautifulhugo ``` あらかじめテーマが決まっているので、ルート配下へコピーします ``` $ cp -r themes/beautifulhugo/exampleSite/* ./ $ cp -r themes/beautifulhugo/layouts ./ $ cp -r themes/beautifulhugo/static ./ ``` 1. ローカルでサイト構築確認 ``` $ hugo server .... Web Server is available at http://localhost:1313/ (bind address 127.0.0.1) ``` これだけでサイト構築が出来るので、ブラウザでhttp://localhost:1313へアクセスし、表示されていることを確認 確認出来たら、hugo server をctrl+cで止める 2. リポジトリ更新 ``` $ git add . $ git commit . $ git push -u origin master ``` 後は、記事を書いたり、環境設定やレイアウトを編集したりして、リポジトリを更新していく -------------------------------------------------------------------------------- title: "yum updateで重複するパッケージのエラーで更新できない" date: "2019-04-26" url: https://scribble.washo3.com/linux/yum-updatede-dupes-error.html -------------------------------------------------------------------------------- CentOS7上にて、yum updateを行った際に、「〜の複製です」とduplicateエラーにて更新出来ない状況に陥ったので、いろんな解決方法を試してみた。 # yum update .... yum-utils-1.1.31-42.el7.noarch は yum-utils-1.1.31-40.el7.noarch の複製です zsh-5.0.2-28.el7.x86_64 は zsh-5.0.2-25.el7_3.1.x86_64 の複製です ## package-clenupで直す * package-clenupがない場合は、yum-utilsをインストール # yum install yum-utils * 重複するパッケージを削除 # package-cleanup --dupes ## package-cleanupで直らない場合 # LANG=C # yum check duplicates | awk '/is a duplicate/ {print $6}' > /tmp/yum.dupes # cat /tmp/yum.dupes .... 1:yelp-3.14.2-1.el7.x86_64 1:yelp-libs-3.14.2-1.el7.x86_64 yelp-xsl-3.14.0-1.el7.noarch yum-plugin-fastestmirror-1.1.31-40.el7.noarch yum-utils-1.1.31-40.el7.noarch zsh-5.0.2-25.el7_3.1.x86_64 # yum remove `cat /tmp/DUPES` ## 別な方法

# yum-complete-transaction # tar cjf /tmp/rpm_db.tar.bz2 /var/lib/{rpm,yum} # yum check &> /tmp/yumcheck # grep "duplicate" /tmp/yumcheck | awk '{ print $NF }' | egrep -v "\:" > /tmp/duplicaterpms # grep "duplicate" /tmp/yumcheck | awk '{ print $NF }' | egrep ":" | awk -F':' '{ print $NF }' >> /tmp/duplicaterpms # for i in $(cat /tmp/duplicaterpms) do rpm -e --justdb --nodeps $i done これで直った! -------------------------------------------------------------------------------- title: "CentOS6上にRSSリーダーのTinyTinyRSSを導入" date: "2019-04-19" url: https://scribble.washo3.com/linux/tinytinyrss-install-on-centos.html --------------------------------------------------------------------------------

Contents

# cd /var/www/html # git clone https://tt-rss.org/git/tt-rss.git tt-rss # chown -R nginx:nginx tt-rss## DB の作成 (admin/password) ※DB名:tt-rss、DBユーザ名:admin、DBユーザパスワード:password とする場合

# mysql -u root -p mysql> CREATE USER ‘admin'@'localhost' IDENTIFIED BY 'password'; mysql> CREATE DATABASE tt-rss CHARACTER SET utf8; mysql> GRANT ALL ON DB_NAME.* TO ‘admin'@'localhost’;または、下記 ## DNS (自分のサイトURL配下に設置する場合は、DNSの設定は必ずしも必要ではありません。) 私の場合、CloudFlareにてreader.yoursite.comの名前でDNS作成 (サイト名は自分用に設定してください) ## letsencryptで証明書作成

$ certbot certonly --standalone -d reader.yoursite.com## nginxのconf作成(SSL対応) tt-rss/utils/gitlab-ci/nginx-defaultが雛形 https://gist.github.com/bjoerns1983/30dff232c8ccede12f6caec7c609b0b6

server_name reader.yoursite.com;

location / {

root /var/www/html/tt-rss;

charset utf-8;

index index.php;

try_files $uri $uri/ /index.php?q=$uri&$args;

include php_exec;

}

# すべての不可視ファイルをアクセス不可にします。

location ~ /\. {

access_log off;

log_not_found off;

deny all;

}

listen 443 ssl https2; # managed by Certbot

by Certbot

ssl_session_timeout 1440m; # managed by Certbot

ssl_protocols TLSv1 TLSv1.1 TLSv1.2; # managed by Certbot

ssl_prefer_server_ciphers on; # managed by Certbot

128-SHA ECDHE-RSA-AES128-SHA256 ECDHE-RSA-AES256-SHA384 DHE-RSA-AES128-GCM-SHA25

6 DHE-RSA-AES256-GCM-SHA384 DHE-RSA-AES128-SHA DHE-RSA-AES256-SHA DHE-RSA-AES128

-SHA256 DHE-RSA-AES256-SHA256 EDH-RSA-DES-CBC3-SHA"; # managed by Certbot

if ($scheme != "https") {

}

## tt-rss設定

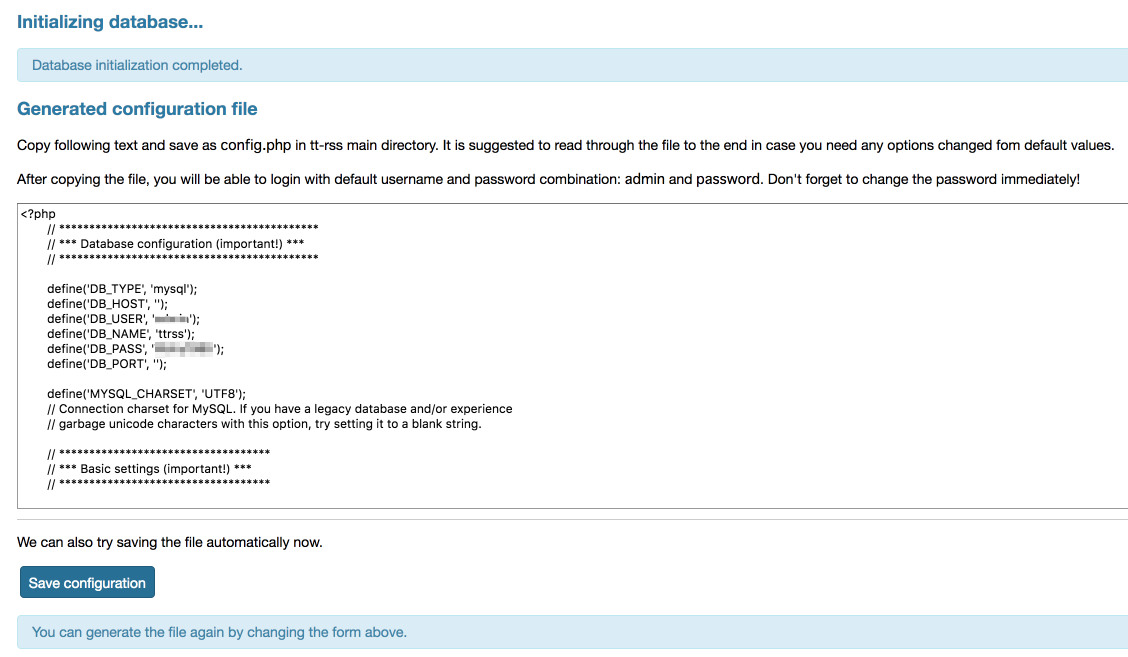

https://reader.yoursite.com/install/へアクセスし、各項目を設定

* MySQLの設定など

* DBホスト名やPortも記述したほうが良い

* 確認のため、config.phpを見ておく

* 初期化

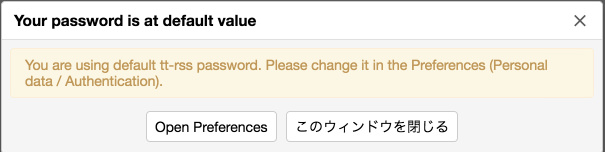

### パスワード変更

admin/passwordでログインし、パスワードを変更しておく

### パスワード変更

admin/passwordでログインし、パスワードを変更しておく

### ユーザー作成

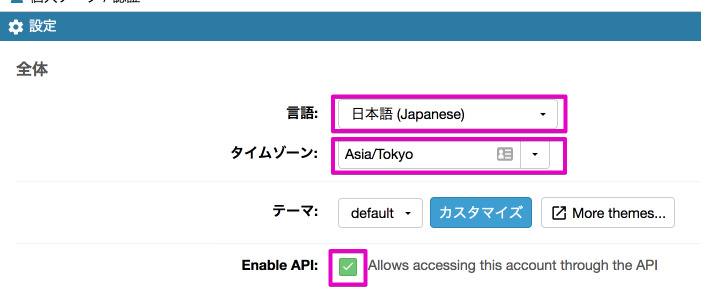

* 言語を日本語

* タイムゾーンをAsia/Tokyo

* APIにチェックマーク

### ユーザー作成

* 言語を日本語

* タイムゾーンをAsia/Tokyo

* APIにチェックマーク

### 外部サービスからインポート

inoreaderの場合

inoreaderからエクスポートし、subscription.xmlをインポートする。

この辺は、GoogleやFeedlyでも同様

### ちょっとしたエラー

* インポートで500 Internal Sever Errorが出る場合

(config.php内にホスト名・ポート番号が未記入もしくはmysqlでflush privilegesが必要だった?)

* 記事の更新が出来ていない・出来ない

下記のディレクトリーを書き込み可にする必要があるようだ。

### 外部サービスからインポート

inoreaderの場合

inoreaderからエクスポートし、subscription.xmlをインポートする。

この辺は、GoogleやFeedlyでも同様

### ちょっとしたエラー

* インポートで500 Internal Sever Errorが出る場合

(config.php内にホスト名・ポート番号が未記入もしくはmysqlでflush privilegesが必要だった?)

* 記事の更新が出来ていない・出来ない

下記のディレクトリーを書き込み可にする必要があるようだ。

# chmod -R 777 lock feed-icons cache/export cache/images cache/upload### 定期的に更新 rootだと動作しないのでnginxで動作させる

# sudo -u nginx crontab -e */15 * * * * /usr/bin/php /var/www/html/tt-rss/update.php --feeds --quiet### Tiny RSSの更新(アップデート)

# cd /var/www/html/tt-rss && git pull-------------------------------------------------------------------------------- title: "ブログをSSL(HTTPS)対応後に、はてなのブログカードが表示されなくなった" date: "2019-04-17" url: https://scribble.washo3.com/wordpress/hatenablogcard-ssl.html -------------------------------------------------------------------------------- このサイトをSSL(HTTPS)化して、しばらく経つのですが、今更ながら、はてなのブログカードが表示されていない事に気づきましたので対処しました。 最近のテーマでは、はてなブログカード対応になっているテーマが多くなってきましたが、ここのサイトのテーマは古いので、独自に対応させております。 こちらのコードを流用させていただいておりましたが、SSL(HTTPS)対応版に修正されておりましたので、対応させていただきました。

はてなブログカード非対応のサイトでも、functions.phpにコードを貼り付けるだけですので簡単ですね -------------------------------------------------------------------------------- title: "muninでエラーメールが頻繁に届くので対処" date: "2019-04-17" url: https://scribble.washo3.com/linux/munin-error-mail.html -------------------------------------------------------------------------------- 以前から、muninで監視されているサーバーから、下記のエラーメールが届いてて、放置状態だったので、対処した。 エラー内容 > [FATAL] There is nothing to do here, since there are no nodes with any plugins. Please refer to https://munin-monitoring.org/wiki/FAQ\_no\_graphs at /usr/share/munin/munin-html line 40 このエラーは、muninサーバーではなく、監視されているmunin-nodeを動作しているサーバーで起きている プラグインによるエラーだと、ほぼ、このコマンドで解消されるWordPressエディターに外部URLをコピペするだけで、どんなサイトでも「はてなブログカード」を表示させるカスタマイズ方法

munin-node-configure --shell | sh -xしかし、これでも解消されず、エラーを吐いているmunin-nodeのサーバー設定を見てみると、なぜかmunin.confが存在している。 通常、監視されているサーバーでは、munin-nodeだけインストールすれば良いのだが、どうやらmuninもインストールされていたようだ。 したがって、muninを削除し、解消された。 もし、削除しなければ、munin.confを下記の設定にて解消されるはず。 /etc/munin/munin.conf

[localhost] address 127.0.0.1 use_node_name yes今回の対処では、こちらの記事を参考にさせていただきました https://mgng.mugbum.info/1454 -------------------------------------------------------------------------------- title: "etckeeperで肥大した/etcをクリーンアップ" date: "2018-12-12" url: https://scribble.washo3.com/linux/etckeeper-git-cleanup.html -------------------------------------------------------------------------------- Linuxで/etcに変更があった場合に、自動的に保存してくれるetckeeperがありますが、使っていくうちに/etc/.git内にファイルが溜まっていく為、/etcが肥大化していきます。 私の環境でも、 ``` # du -hsc /etc/.git

16G /etc/.git

16G 合計 ``` なんと、16GBも容量が肥大しておりました なので、gitのクリーンアップオプションで整理(クリーンアップは自己責任で行ってください) ``` # cd /etc/ # git gc # du -hsc /etc/.git 56M /etc/.git 56M 合計 ``` かなりスッキリしました。 Etckeeperは便利ですが、yumで更新が大量に入ると、圧縮に時間がかかってしまうので、総じて作業時間がかかってしまうのが難点ですね -------------------------------------------------------------------------------- title: "PHPのUse of undefined constant警告の対処" date: "2018-12-12" url: https://scribble.washo3.com/linux/php-use-of-undefined-constant.html -------------------------------------------------------------------------------- php-fpmのログに下記の警告が出てた `PHP Warning: Use of undefined constant ’128M’ - assumed '’128M’' (this will throw an Error in a future version of PHP)` WordPressのwp-config.phpにmemory limit設定に128Mを指定した欄が該当していたらしく、この欄だけアポストロフィー表記になっていました。 対策は、「‘」「’」を半角のシングルクォーテーション「’」へ変更する事で解決です。 phpコーディングでは、シングルクォーテーションにしておいた方が無難です。 また、ネット上からコピペする際は、アポストロフィーになっている事が多いので注意が必要ですね。 -------------------------------------------------------------------------------- title: "CentOS6系のPHP5.xを7.xへアップデート" date: "2018-12-11" url: https://scribble.washo3.com/linux/centos6-php5_to_php7.html --------------------------------------------------------------------------------

Contents

PHP 5.6.35 (cli) (built: Mar 29 2018 07:37:47)

Copyright (c) 1997-2016 The PHP Group

Zend Engine v2.6.0, Copyright (c) 1998-2016 Zend Technologies` ### 旧バージョンの削除 `# yum remove php-*` (zshだと php-¥*) ### epelとremiのインストール確認 remiは6系のものでOK (remiは最新のもので、priority=1)推薦 `# vi /etc/yum.repos.d/remi-php73.repo

[remi-php73]

priority=1

....` /etc/yum.repo.d/内にremi-php7*.repoがあることを確認 ### 念の為、yumのキャッシュを削除 `# yum clean all` ### 7.xをインストール nginx版 `# yum install --enablerepo=remi-php73 php php-fpm php-mcrypt php-cli php-common php-devel php-gd php-mbstring php-mysqlnd php-opcache php-pdo php-pear php-pecl-apcu php-pecl-zip php-process php-xml` Apache版 `# yum -y install --enablerepo=remi,remi-php73 php php-devel php-mbstring php-mysql php-pdo php-gd` 補足:—————————————————————— libargon2の依存関係でアップデート処理が止まる場合は、remiのリポジトリを最新にするか再インストール https://www.riscascape.net/archives/16990 ### php7.3の確認 `$ php -v

PHP 7.3.0 (cli) (built: Dec 4 2018 20:10:48) ( NTS )

Copyright (c) 1997-2018 The PHP Group

Zend Engine v3.3.0-dev, Copyright (c) 1998-2018 Zend Technologies

with Zend OPcache v7.3.0, Copyright (c) 1999-2018, by Zend Technologies` ZendEngineもZendOPcacheに変更され、APCuも導入済みとなっております OPcache、APCuの設定については、初期設定のまま使用します ### php-fpmの設定 下記環境は、個々に違いがあるので自分の環境に合わせてくださいね `# vi /etc/php-fpm.d/www.conf

listen = 127.0.0.1:9000

listen.owner = nobody

listen.group = nobody

listen.mode = 0660

user = apache

group = apache

pm = static

` 保存後、php-fpmを再起動します。 `# /etc/init.d/php-fpm restart` ### php.iniの再設定 `default_charset = UTF-8

mbstring.language = Japanese

mbstring.encoding_translation = Off

mbstring.detect_order = UTF-8,SJIS,EUC-JP,JIS,ASCII

date.timezone = Asia/Tokyo

expose_php = Offmemory_limit = 128M

post_max_size = 128M

upload_max_filesize = 128M

memory_limit = 128M

date.timezone = "Asia/Tokyo"

` 保存後、nginx再起動 `# /etc/init.d/nginx restart` -------------------------------------------------------------------------------- title: "CentOSのyum更新で衝突しまくり" date: "2018-05-16" url: https://scribble.washo3.com/linux/centos7-5-yum-conflict.html -------------------------------------------------------------------------------- CentOS 7.4で、久しぶりにyum更新したら、下記のように衝突が発生 > …. > —> パッケージ rdma-core.x86_64 0:15-6.el7 を アップデート > —> パッケージ tar.x86_64 2:1.26-32.el7 を 更新 > —> パッケージ tar.x86_64 2:1.26-34.el7 を アップデート > –> 衝突を処理しています: initscripts-9.49.41-1.el7.x86_64 は redhat-release < 7.5-0.11 と衝突しています > –> 依存性解決を終了しました。 > 問題を回避するために –skip-broken を用いることができます。 –skip-brokenにすれば、衝突していないパッケージは更新され、衝突パッケージではexcludeを設定することで回避できるのですが、今回のは衝突が多すぎました。 ん? よく見ると、”7.5-0.11 と衝突しています” 7.5がリリースされ、更新が多いのかと思い、頭をよぎったのが・・・ yum.confの除外設定で、kernelを除外設定にしていた影響です。 exclude=kernel* この除外設定を無効にしたのち、yum更新したところ、はい、無事に衝突が起こらずに、7.5へアップデートされたとさ。 自業自得でした。m(_ _)m 参考までにCentOS 7.4から7.5へのアップデート https://www.cyberciti.biz/linux-news/rhel-7-5-released-how-to-upgrade-7-4-to-7-5/ -------------------------------------------------------------------------------- title: "ChromeのHSTS解消メモ" date: "2018-04-24" url: https://scribble.washo3.com/network/chrome-hsts-howto.html -------------------------------------------------------------------------------- Google Chromeにて、httpsを指定しているにも関わらず、httpsへ勝手にリダイレクトし、httpsではアクセス出来ない事が多いので、メモです。 HSTSは、HTTP Strict Transport Securityの略で、httpsの代わりにhttpsを用いて通信を行うセキュリティ機能です。 詳しくは、下記のブログをご覧いただければと思います。 ### 解決方法 Google ChromeのURLアクセスバーに、

chrome://net-internals/#hstsと入力し、下部にある「Delete domain security policies」で該当するドメイン名を入力し、deleteを押すだけです。 これでも、変化がないようであれば、Google Chromeを再起動、キャッシュの削除、クッキーの削除を行ってみましょう。 -------------------------------------------------------------------------------- title: "letsencrypt更新でEPELを要求" date: "2018-03-30" url: https://scribble.washo3.com/security/letsencrypt-epel-enabled.html -------------------------------------------------------------------------------- letsencryptの証明書が切れたので、再発行によるコマンドを叩いたら、下記のエラーで更新できず。

# ./letsencrypt-auto certonly --standalone -d <domain> --renew-by-default> To use Certbot, packages from the EPEL repository need to be installed epelのパッケージは導入済みで、最新のパッケージがインストールされてますよ〜って止まる これ、インストールの他に有効にしなさいと言うメッセージが抜けてるね `/etc/yum.repo.d/epel.repo

enable = 1 # 0から1へ変更` 再度、再発行コマンドで無事通りました -------------------------------------------------------------------------------- title: "etckeeperで/etcをgit管理" date: "2018-02-06" url: https://scribble.washo3.com/linux/etckeeper-git.html -------------------------------------------------------------------------------- /etcをGit管理出来るetckeeperは以前か知っていたのだが、放置したままだったので、今更導入してみた。 ### インストール #### Redhat系

# yum -y install etckeeper --enablerepo=epel#### Debian系

# ap-get -y install etckeeper### 設定 /etc/etckeeper/etckeeper.confの下記箇所を確認及び追記

VCS="git" PUSH_REMOTE="origin"### 初期化

# cd /etc/ # etckeeper init#### origin追加

# git remote add origin git_url#### コミット

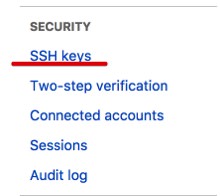

# etckeeper commit -m 'first commit'### bitbucketの利用 githubでもやることは同じ * bitbucketにログインし、リポジトリを作成 * etckeeper側ホストでoriginの登録

# git remote add origin git@bitbucket.org:user/repo* ssh鍵の登録 etckeeper側ホストでrootにて、鍵がなければを作成する(パスは空で)

# sh -c 'ssh-keygen ; less /root/.ssh/id_rsa.pub’表示されたssh鍵をbitbucket側に登録する

### 自動実行

etckeeperをインストールした時点で、/etc/cron.dailyにスクリプトが作成されるので、毎日自動で/etc内を更新してくれるようになっています。

一度、手動実行して、無事に登録出来るのか確認してみると良いでしょう。

```

# /etc/cron.daily/etckeeper

```

--------------------------------------------------------------------------------

title: "古いCentOSのリポジトリを復活させる"

date: "2018-01-09"

url: https://scribble.washo3.com/linux/centos5-x-yum-vault.html

--------------------------------------------------------------------------------

職場のサーバーで、未だにCentOS 5.11を使い続きているサーバーがあるのですが、CentOS 5系は昨年の3月でサポート終了となり、アップデートも行われません。

それは、承知なのですが、時に、足りなかったプログラム等をインストールしたい時が生じます。

しかし、yum更新はおろか、yumによるプログラムのインストールさえ行えません。

\# yum install xxxxx

> YumRepo Error: All mirror URLs are not using ftp, https[s] or file.

> Eg. Invalid release/

> removing mirrorlist with no valid mirrors: /var/cache/yum/base/mirrorlist.txt

> Error: Cannot find a valid baseurl for repo: base

既にサポートが終了しており、ミラーリストにも存在していないようですが、幸いにもvault.centos.orgが引き継いでくれているようで、baseurlをここへ向けることで対処することが出来ます。

/etc/yum.repos.d/CentOS-Base.repoのバックアップをとり、下記に書き換えます。

### 自動実行

etckeeperをインストールした時点で、/etc/cron.dailyにスクリプトが作成されるので、毎日自動で/etc内を更新してくれるようになっています。

一度、手動実行して、無事に登録出来るのか確認してみると良いでしょう。

```

# /etc/cron.daily/etckeeper

```

--------------------------------------------------------------------------------

title: "古いCentOSのリポジトリを復活させる"

date: "2018-01-09"

url: https://scribble.washo3.com/linux/centos5-x-yum-vault.html

--------------------------------------------------------------------------------

職場のサーバーで、未だにCentOS 5.11を使い続きているサーバーがあるのですが、CentOS 5系は昨年の3月でサポート終了となり、アップデートも行われません。

それは、承知なのですが、時に、足りなかったプログラム等をインストールしたい時が生じます。

しかし、yum更新はおろか、yumによるプログラムのインストールさえ行えません。

\# yum install xxxxx

> YumRepo Error: All mirror URLs are not using ftp, https[s] or file.

> Eg. Invalid release/

> removing mirrorlist with no valid mirrors: /var/cache/yum/base/mirrorlist.txt

> Error: Cannot find a valid baseurl for repo: base

既にサポートが終了しており、ミラーリストにも存在していないようですが、幸いにもvault.centos.orgが引き継いでくれているようで、baseurlをここへ向けることで対処することが出来ます。

/etc/yum.repos.d/CentOS-Base.repoのバックアップをとり、下記に書き換えます。

[base] name=CentOS-$releasever - Base baseurl=https://vault.centos.org/5.11/os/$basearch/ gpgcheck=1 gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5 [updates] name=CentOS-$releasever - Updates baseurl=https://vault.centos.org/5.11/updates/$basearch/ gpgcheck=1 gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5 [extras] name=CentOS-$releasever - Extras baseurl=https://vault.centos.org/5.11/extras/$basearch/ gpgcheck=1 gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-5これで、CentOS 5.xでもパッケージのインストールが可能となります。 Vaultのサポートがいつまで続くのかわからないし、セキュリティ的にも最新のOSへ移行したほうが賢明なのはわかっているのですがね・・ -------------------------------------------------------------------------------- title: "Mac版VirtualBoxのインストールが検証中のまま進まない問題" date: "2017-12-17" url: https://scribble.washo3.com/mac/mac-virtualbox-verifying.html -------------------------------------------------------------------------------- VirtualBoxは、1年に数回しか起動しないので、久しぶりに起動すると、アップデートを必ず促されるので、アップデートを行っていますが、毎回、Mac版VirtualBoxのインストーラーが検証中のまま進まないので、メモしておく。

Contents

# service nginx stop### 古い証明書関連ファイルやディレクトリを削除 下記に古いファイルやディレクトリが保存されているので、該当するドメインを削除します * /etc/letsencrypt/live/ * /etc/letsencrypt/archive/ * /etc/letsencrypt/renewal/ ### 証明書新規作成 私の環境では、/var/opt/letsencrypt/に格納されているので、

# cd /var/opt/letsencrypt/ # ./certbot-auto certonly --standalone -d foo.bar.com複数ドメインがある場合 -d オプション後に続けて明記するような記事もあるのですが、上手くいかなかったので、複数ある場合でも一つずつ行う必要がありました。 ### ウェブサーバー起動

# service nginx startここまでで証明書再作成作業は終了です。 ## メンテナンス ### 更新 期限まで30日未満のものを更新

# ./certbot-auto renew### 全ての証明書を強制更新

# ./certbot-auto renew —force-renew### 自動更新 更新切れを気にする必要がないように、cronで自動更新した方が楽です 毎月の1日に更新するように設定

# cd /etc/cron.d # vi letsencrypt 0 0 1 * * root /var/opt/letsencrypt/certbot-auto renew --post-hook "service nginx restart"-------------------------------------------------------------------------------- title: "QNAP再起動後にNFSでマウントできなかった" date: "2017-11-06" url: https://scribble.washo3.com/linux/qnap-nfs-permission-denied.html -------------------------------------------------------------------------------- QNAPをNFSサーバーにして、各クラアントからAutofsでマウントして、正常に動作していたはずなのに、QNAPを再起動した後から、NFSによるマウントが出来なくなってしまった。 数台のクライアントからAutofsでQNAPにマウント出来ていたはずが、どれも、正常にマウントしない症状。 QNAP上のNFSを再起動してみても変わらずで、mountの詳細を見てみると、 > mount.nfs: mount(2): Permission denied > mount.nfs: access denied by server while mounting 192.168.1.2:/data 明らかにサーバー側で拒否されてる QNAPサーバー側では、接続してくるIPを制限しているので、QNAPへSSHで入り、/etc/exportsを確認してみた所、 > “/share/MD0\_DATA/data” 192.168.1.1192.168.1.1.2192.168.1.3(rw,async,no\_subtree\_check,insecure,no\_root_squash) 許可するIP部分が勝手に連結されているのが原因でした。 exportsを書き換えても、ウェブ管理画面のGUIで設定を行うと再び連結されるので、QNAPマネージャーのバグなのでは? 仕方ないので、ウェブ管理画面上の権限設定→共有フォルダ→アクションボタンの共有フォルダ権限の編集→権限タイプの選択でNFSホストのアクセスに進み、接続を許可するIPを一つづつ記入し、適用する事で、各クライアントから正常にAutofsが働くようになった。 何だかんだQNAPのバグには悩まされる… -------------------------------------------------------------------------------- title: "PHP5.6のgd-lastがyum更新で失敗する" date: "2017-09-08" url: https://scribble.washo3.com/linux/redhat-php56-gd-last.html -------------------------------------------------------------------------------- CentOS/SL6のyumにて、いつも通り更新を行ってましたが、gd-lastで引っかかってました。 > エラー: パッケージ: gd-last-2.2.5-1.el6.remi.x86_64 (remi) > 要求: libwebp.so.5()(64bit) libwebpを要求しているようなので、epelからlibwebpをインストールするだけで解決

epelがまだインストールされていない方は、 # yum -y install epel-release # yum update

libwebpをインストール # yum -y install libwebp --enablerepo=epel gd-lastをインストール # yum -y install gd-last --enablerepo=remi-------------------------------------------------------------------------------- title: "Coreserverリニューアル後にWordPress閲覧不可に" date: "2017-08-29" url: https://scribble.washo3.com/wordpress/coreserver-renew-wordpress-trouble.html -------------------------------------------------------------------------------- Coreserver上にて、とあるブログサイトをWordPressで運用していたのですが、数日前から閲覧不可になってた。 どうやら、Coreserverにて大規模なリニューアルが行わたのが原因のようです。 https://www.coreserver.jp/info/brandnew2017/ CPUコア数やメモリ増強、SSD対応など機能的にはかなりアップしたようなのですが、PHP/MySQL/Apacheなども最新のバージョンが採用された影響で、今まで動作していたWordPressが動作しなくなってしまいました。 調べてみると、WordPress自体が動作していなく管理画面すら入れない状況でした。 画面上では、真っ白で何も表示されていないので、SSHでログインし、デバッグを有効にしてみました。 すると、下記のようなエラーが残されていました。 > PHP Warning: require_once(/wp-content/plugins/db-cache-reloaded-fix/db-module.php) db-cache-reloaded-fixのプラグインが既に更新されておらず、PHP71にも対応していないようなので、WordPress管理画面にも入れないのでプラグインディレクトリからdb-cache-reloaded-fixを除外。 しかし、それでも同様のエラーが表示されるので、キャッシュディレクトリ内を削除。 これでもエラーが解決されないので、プラグインディレクトリ自体をリネームしてみました。 やはり、同様のエラーが続くので、調べてみると、wp-content内にdb-cache-reloaded-fixがdb.phpを作成するらしく、これも削除しなければならないようでした。 そして、他のプラグインを戻してみましたが、やはりWordPressは動作せず。 仕方ないので、「[PHPスクリプトが動かなくなりました][1]」の対応通りにPHP5.xに戻してみたところ、一瞬だけWordPress画面だけ表示されましたが、すぐに真っ白な画面に戻った。 もうプラグインやテーマ内の不具合を探すのが億劫になってきて、新規にWordPressを作成し、MySQLのデータベースだけを読み込んでみた方がてっとり早いと思ったら、なんと文字化け。 エンコードをEUCやSHIS、UTF8など、どれを選択しても化ける。 「[PHPで構築したページが文字化けしている][2]」を参考に、PHPやらMySQL関連を弄ってみるが、全てをUTF8になっているはずなのに、一向に文字化けが治らない。 さて、どうしたものかと、WordpressのMySQLデータ内部を覗いてみると、データ部が文字化けしている。 一週間前にDBのバックアップを取っていたので、それと比較してみた所、バックアップのDBは文字化けしていない事が判明。 結局、PHP71+MySQL5.7の最新バージョン上にて、WordPressを新規構築し、インポートしたバックアップのDBを読み込むことで、復旧した。 尚、Coreserver上でFast-cgiを利用する場合には、php.iniに相当するファイルも設定する必要があるので、下記を参考にすることもお忘れなく! https://www.coreserver.jp/support/faq/php-cgi.php 1日がかりで疲れたわ。 [1]: https://www.coreserver.jp/info/brandnew2017/#q07 [2]: https://www.coreserver.jp/info/brandnew2017/#q08 -------------------------------------------------------------------------------- title: "Dockerのインストール方法が変わってた" date: "2017-08-22" url: https://scribble.washo3.com/linux/docker-ce-install.html -------------------------------------------------------------------------------- DockerがCE/EEとなり、インストール方法が変わってるんですね。 公式やQuiita参照で、ほぼ解決します https://docs.docker.com/engine/installation/linux/docker-ce/debian/#prerequisites https://qiita.com/adnap2501/items/e00248dd697059969203 古いバージョンをアンイストして、入れたほうが良いかもしれません。 新しいリポジトリ追加して、apt更新時に上手く取得できない症状に遭遇しましたが、 そのままインストールしちゃいました。 docker-composeもaptでインストール出来るので楽ですね ちなみに、Redhat/CentOS系は下記のQuiitaで良いでしょう https://qiita.com/sawadashota/items/2bed41598d825d488701 -------------------------------------------------------------------------------- title: "Debian 8.9から9.1へアップグレード" date: "2017-08-22" url: https://scribble.washo3.com/linux/debian-8to9-upgrade.html -------------------------------------------------------------------------------- Debian 8.9を9.1へアップグレードした。 ほぼ、下記の記事で完了 感謝! Debian 9.xからカーネルがLinux4.9 LTSへ、またsystemdが採用されてるので、注意。 -------------------------------------------------------------------------------- title: "dyld: Library not loaded: /usr/local/opt/jpeg/lib/libjpeg.8.dylib" date: "2017-08-22" url: https://scribble.washo3.com/mac/homebrew-dyld-jpeg.html -------------------------------------------------------------------------------- 久しぶりにHomebrewでUpgradeかけたら、下記のエラーが出た > dyld: Library not loaded: /usr/local/opt/jpeg/lib/libjpeg.8.dylib ほぼ、下記の記事が参考になる https://qiita.com/maimai-swap/items/9ba6e5f877274079d755 私の環境の場合、jpegのバージョン8d,9bが混在しているようなので、下記のコマンドで戻せばOKでした。

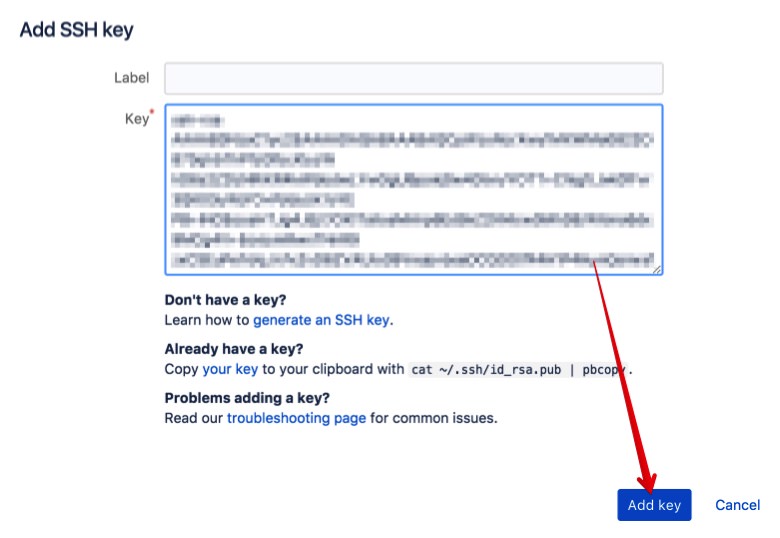

# brew switch jpeg 8d-------------------------------------------------------------------------------- title: "ESXiでゲストOS新規作成でネットワークデバイスが認識されない?" date: "2017-08-22" url: https://scribble.washo3.com/%E4%BB%AE%E6%83%B3%E5%8C%96/esxi-guestos-create-no-network-device.html -------------------------------------------------------------------------------- ESXi上で、普通にLinuxのゲストOSを作成しようとしたら、ネットワークデバイスが認識されてない?

ESXiのバージョンはそのままで、今まで、何度もLinuxのゲストOS作成しているので、OSが新しく(今回はCentOS7)なったことにより、デバイスが認識されなくなったのかと思ったら、初歩的なミスでした。

新規仮想OSを作成する際に、アダプタがVMware独自のVMXNETになっていただけでした。(^_^;)

ESXiのバージョンはそのままで、今まで、何度もLinuxのゲストOS作成しているので、OSが新しく(今回はCentOS7)なったことにより、デバイスが認識されなくなったのかと思ったら、初歩的なミスでした。

新規仮想OSを作成する際に、アダプタがVMware独自のVMXNETになっていただけでした。(^_^;)

<Directory "/var/www/html"> ... ... Require GET POST </Directory>Require記述は、2.4系からなので、Require行を削除したところ、復帰しました。 Requireの書式を記述しても、configtestは通って、Syntax OKになるので注意ですね。 -------------------------------------------------------------------------------- title: "今更ながらSubsonicをSSLでサブドメインにて運用" date: "2017-02-17" url: https://scribble.washo3.com/linux/subsonic-ssl-subdomain.html -------------------------------------------------------------------------------- このサイトでも幾度か、Subsonicの記事を投稿しておりますが、今更ながら、SSL証明書によるHTTPS化して、ついでにサブドメインにてアクセスするように設定した。 **環境** * CentOS 6.x * Nginx 1.10.x (ssl設定済み) * Subsonic 6.0 * DNS管理はCloudFlare * SSL証明書はLet’sEncyptにて取得 現状は、CentOS上にSubsonicを運用しており、https://localhost:4040にて稼働しております。

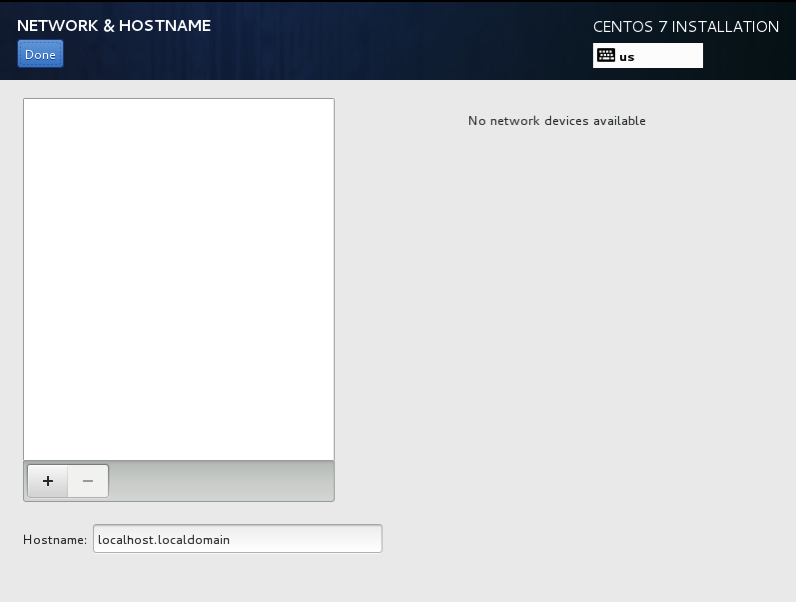

Contents

* 左のレコードタイプをA

* 次にサブドメイン名(今回はsubsonic)

* サブドメインのIPアドレス (通常、subsonicを動作させているIP)

* TTLは通常Automaticですが、早く反映させたいので、2min

DNS反映後は、Automaticに戻しましょう

* CloudFlareを通さない設定にしておかないと、この後の証明書発行ができませんので、雲マークがオレンジではなくグレイになるようにクリックしておきます

DNS反映には、しばらく時間がかかるので、コーヒーを飲んだり出かけたりすると良いかもしれません

一応、確認としては、CloudFlare上で設定が反映されていれば、

$ dig @ns6.cloudflare.com subsonic.xxx.xxx にて、設定したIPアドレスが表示されればOK

そして、サブドメイン(subsonic)上の端末から、

$ dig subsonic.xxx.xxx にて設定したIPアドレスが表示されれば、次に進めます

### NginxのSubsonicサブドメイン用設定ファイル作成

設定ファイルは、/etc/nginx/sites-available/内にsubsonic.confと言う名前(任意でも)で作成します。

* 左のレコードタイプをA

* 次にサブドメイン名(今回はsubsonic)

* サブドメインのIPアドレス (通常、subsonicを動作させているIP)

* TTLは通常Automaticですが、早く反映させたいので、2min

DNS反映後は、Automaticに戻しましょう

* CloudFlareを通さない設定にしておかないと、この後の証明書発行ができませんので、雲マークがオレンジではなくグレイになるようにクリックしておきます

DNS反映には、しばらく時間がかかるので、コーヒーを飲んだり出かけたりすると良いかもしれません

一応、確認としては、CloudFlare上で設定が反映されていれば、

$ dig @ns6.cloudflare.com subsonic.xxx.xxx にて、設定したIPアドレスが表示されればOK

そして、サブドメイン(subsonic)上の端末から、

$ dig subsonic.xxx.xxx にて設定したIPアドレスが表示されれば、次に進めます

### NginxのSubsonicサブドメイン用設定ファイル作成

設定ファイルは、/etc/nginx/sites-available/内にsubsonic.confと言う名前(任意でも)で作成します。

# cat subsonic.conf

server {

listen 80;

server_name subsonic.xxx.xxx;

access_log /var/log/nginx/subsonic-access.log;

error_log /var/log/nginx/subsonic-error.log;

location / {

proxy_pass https://127.0.0.1:4040;

proxy_redirect https:// https://;

}

保存後に、sites-enabled内にシムリンクを張ります

# ln -s /etc/nginx/sites-available/subsonic.conf /etc/nginx/sites-enabled/書式に間違いないか確認

# service nginx configtestエラー表示がなく、Syntax OKが表示されれば、適用します

# service nginx reloadこれで問題がなければ、サブドメインのURLでアクセスすると、Subsonicの画面が表示されるはずです。 ### SSL証明書取得・設定 ここでは、無料のSSL証明書(Let’sEncypt)をサブドメインに適用します #### Let’sEncryptをインストール すでに、Let’sEncryptのプログラムは導入済みなのですが、初めての方は下記でインストールします。

# git clone https://github.com/letsencrypt/letsencrypt <directory> # cd <directory>#### サブドメイン用の証明書取得 \# ./letsencrypt-auto —nginx (初めて起動の方は、ここで、いろいろなプログラムがインストールされます) > 1. aaa.xxx.xxx > 2. bbb.xxx.xxx > 3. subsonic.xxx.xxx > …. サーバー内nginx設定ファイルが自動で読み込まれるので、適用するドメインを使用します。 ここでは、subsonicなので3を選択 登録するにあたり、規約のPDFを見て承諾するか尋ねられるので、AgreeのAを打ち込む 初めての方は、登録するメールアドレスを求められるので記入します > 1: Easy – Allow both HTTP and HTTPS access to these sites > 2: Secure – Make all requests redirect to secure HTTPS access 今まで通りhttpsでもアクセス可能にするか、全てhttpsで接続させるかを任意で指定 これで、Congratulations!が表示されれば、サブドメインのsubsonic.confにssl設定が追記されています 一応、設定ファイルを読み込んでおきます

# service nginx reloadそして、サブドメインのSubsonic(subsonic.xxx.xxx)へhttpsでアクセスして、httpsへリダイレクトされてログイン出来れば完成です。 作業時間より、この記事書くほうが時間かかってしまいました。(^_^;) -------------------------------------------------------------------------------- title: "DockerでOpenVAS起動" date: "2017-02-17" url: https://scribble.washo3.com/linux/howto-openvas_on_docker.html -------------------------------------------------------------------------------- 脆弱性をスキャンするソフトにOpenVASと言う無償ソフトがあります。 一時的に利用するのであれば、Docker上で起動したほうが楽ですね。 Dockerが起動する環境にある事が前提で、DockerHubのOpneVASを利用します。 https://hub.docker.com/r/mikesplain/openvas/

Contents

..... ``` -------------------------------------------------------------------------------- title: "SSL(HTTPS)で画像が読み込まれなくハマった" date: "2017-02-16" url: https://scribble.washo3.com/linux/ssl-images-cannot-load.html -------------------------------------------------------------------------------- とあるサイトで、サイトをSSL化(HTTPS)したところ、画像だけが読み込まれないトラブル 環境は、CentOS7上のApache 2.4で、ssl.confを主体に、confファイルをいろいろ調べてみても解決せずにハマりました。 原因は、「画像の直リンク禁止」設定にしていたからでした。 画像ディレクトリ(images)内の、.htaccessで下記のように直リンク禁止設定にしていました。 `

SetEnvIf Referer “https://www.xxx.xxx/" OK

SetEnvIf Referer “https://localhost/" OK

Order allow,deny

allow from 127.0.0.1

allow from env=OK

問題なく設定も引き継がれたのですが、ブラウザで開いてみたところ、下記のエラーが出るようになりました。 > Failed to find parameter: instanceId (check server log for more info). どうやら、ブラウザのキャッシュの問題のようで、ブラウザを変更してみるか、ブラウザのキャッシュ・クッキーを削除して解決 -------------------------------------------------------------------------------- title: "Zabbixサーバとエージェントの通信が取れないよくある症状" date: "2016-08-24" url: https://scribble.washo3.com/linux/zabbix-agent-trouble-faq-2016.html -------------------------------------------------------------------------------- Zabbixサーバーが既に稼働してあるものとして、情報を取りたいエージェント(Agent)側にzabbix agentをインストールすることが多々あります。 そのままインストールして、デフォルトのまま起動すると、大抵、サーバー側と通信取れないことがよくあるのでメモしておきます。 Zabbix Agentのインストール手順については割愛します。(yum,aptでzabbix agentをインストールするだけなので) ### 確認事項と対応 #### ファイヤーウォール * 使用しているOSのファイヤーウォールが起動しているのか? * ファイヤーウォールでポートがブロックされていないか? * SELinuxが起動していないか? SELinuxやファイヤーウォール(iptables)が起動していたら、一旦無効にしてみましょう。(手っ取り早いので) #### zabbix_agentd.confの設定 デフォルトでは、#Server = 127.0.0.1となっているので、ここをZabbixサーバーのIPに変更しましょう。 デフォルトのままの設定で通信出来ない場合は、下記のようなログが残っているはずです。

failed to accept an incoming connection: connection from “xxx.xx.xx.xx" rejected, allowed hosts: "127.0.0.1"#### PIDが作成出来ないエラーの場合 稀に、zabbix agent起動時に、PIDファイルが作成出来なくて、起動に失敗する場合があります。 ログを確認すると、下記のようなエラー

zabbix_agentd [890]: cannot create PID file [/var/run/zabbix/zabbix_agentd.pid]: [2] No such file or directoryこれは、OSを再起動した際に、tmpfsの影響により、ディレクトリやファイルが消される場合があります。 この場合には、/var/run/zabbixのディレクトリがあるか確認することとパーミッションを確認しましょう。

# mkdir /var/run/zabbix # chown zabbix:zabbix /var/run/zabbixこの後に、zabbix agentを再起動し、/var/run/zabbix/zabbix_agentd.pidが作られていることを確認 #### その他 現在のZabbix最新版は3.xであり、以前からzabbixを利用していれば2.x以前を利用している場合もあるかと思います。 バージョンによる不具合も起きるかもしれませんので、なるべくバージョンは合わせたほうが良いでしょう! -------------------------------------------------------------------------------- title: "Debian8へZabbix 3.x Agentのインストール" date: "2016-08-24" url: https://scribble.washo3.com/linux/debian8-zabbix-agent-install.html -------------------------------------------------------------------------------- ### Debian8へZabbix 3.xのインストール Debianデフォルトのzabbixパッケージは、2.xと古いので、3.xのリポジトリを追加してインストールする手順です。 #### リポジトリ追加

# wget https://repo.zabbix.com/zabbix/3.0/debian/pool/main/z/zabbix-release/zabbix-release_3.0-1+jessie_all.deb # dpkg -i zabbix-release_3.0-1+jessie_all.deb # apt-get update#### zabbix-agentインストール

# apt-get install zabbix-agent#### サーバー先の設定 zabbix agentはサーバーへ情報を送るプログラムなので、情報を送るサーバーIPを記述する必要があります。

# vi /etc/zabbix/zabbix_agentd.conf .... Server=127.0.0.1 <--このIPを修正します ....保存後に、zabbix agentを再起動

# systemctl restart zabbix-agent.service#### Zabbixサーバー ちなみに、Zabbixサーバーをインストールするには下記でインストール

# apt-get install zabbix-server-mysql zabbix-frontend-php今回のZabbix agentを含め、Debianにかぎらず、サーバーをインストールした後には、設定ファイルやPHP環境を変更する必要があるので、下記公式の記事を参照です。 https://www.zabbix.com/documentation/3.0/manual/installation/install\_from\_packages#debianubuntu -------------------------------------------------------------------------------- title: "3Wareドライバーの在り処" date: "2016-08-24" url: https://scribble.washo3.com/linux/3ware-driver-url.html -------------------------------------------------------------------------------- Debianで動作していたLinux機が起動出来なくて、OS再インストールした際に、RAIDカードの3ware製ドライバーのリンク先が変更されていたようで、結構手間取ってしまった。 以前は、3ware.comでしたが、下記URLに変更されていたんですね。 https://www.avagotech.com/support/download-search せっかくなので、ついでにインストールのメモ

Contents

# unzip 3DM2_CLI-linux_***.zip # chmod 755 install.sh # ./install.sh -i .......... Press Y to accept the License Agreement or N to decline (and exit) then press 'Enter Key': Y (Yを入力する) 3ware CLI & 3DM2 installation, configuration and removal script. (c) 2010 LSI, Inc. All rights reserved. Script version: v3.00.00.021 ******************************* 3DM2 supports two modes of operation. ------------------------------------- 0 - 3DM2 with WEB interface 1 - 3DM2 Error/Event Logger only Which version of 3DM would you like configured? (0|1) 0 (0を入力) *** 3DM2 selected. *** *** Installing 3DM2 and CLI *** Press 'Enter Key' to continue with installation or Control C to exit. Creating installation tmp directory /tmp/3ware... done. Extracting installation files to /tmp/3ware... done. Changing directory to /tmp/3ware to continue installation done. Creating 3dm2 configuration directory (/etc/3dm2)... done. Creating 3dm2 install path (/opt/3ware/3DM2)... done. Creating 3dm2 message file install path (/opt/3ware/3DM2/msg)... done. Creating 3dm2 help file install path (/opt/3ware/3DM2/help)... done. Creating CLI install path (/opt/3ware/CLI)... done. ****************************************** **** Installing 3DM2 files for x86_64 ****************************************** Copying install.sh to /opt/3ware... done. Installing 3dm2u binary to /opt/3ware/3DM2... done. Setting runtime permissions for /opt/3ware/3DM2/3dm2... done. Installing 3dm2 message files to /opt/3ware/3DM2/msg... done. Installing 3dm2 help files to /opt/3ware/3DM2/help... done. Installing 3dm2 configuration file to /etc/3dm2... done. Installing 3dm2 logo file to /etc/3dm2... done. Installing /etc/init.d/tdm2 script... done. Setting runtime permissions for /etc/init.d/tdm2... done. ****************************************** **** Installing CLI files for x86_64 ****************************************** Installing CLI binary to /opt/3ware/CLI/tw_cli... done. Setting runtime permissions for /opt/3ware/CLI/tw_cli... done. Installing CLI html help to /opt/3ware/CLI... done. Installing CLI man page to /usr/share/man/man8... done. *************************************** **** Configuring CLI & 3DM2 *************************************** Creating /usr/sbin/3dm2 symbolic link to /opt/3ware/3DM2/3dm2... done. Creating /usr/sbin/tw_cli symbolic link to /opt/3ware/CLI/tw_cli... done. Setting runtime permissions for /etc/3dm2/3dm2.conf... done. *************************************** **** Finishing Installation *************************************** *** Starting 3DM2 using configuration found in /etc/3dm2/3dm2.conf *** [ ok ] Starting tdm2 (via systemctl): tdm2.service.今回は、対話モードでのインストールでしたが、対話無しで一気にインストールする場合は、下記で。

# ./install.sh --install -fN0#### 確認

ps aux|grep 3dm root 14492 0.0 0.0 77220 2744 ? Sl 09:21 0:00 /usr/sbin/3dm2#### 接続

https://localhost:888/ Administratorでログインする 初期パスワードは3ware#### 補足 自Linux上のFirefoxからlocalhost:888にアクセスしても、接続出来ないので、ファイヤーウォールやらポート確認してみましたが、問題ないので、他端末のGoogle Chromeでアクセスしたところ、無事にアクセスすることが出来た。 Firefoxだけの原因のようで、下記の何れかに該当するのかもしれません。 https://support.mozilla.org/ja/kb/firefox-cant-load-websites-other-browsers-can 追記:私の環境の場合、httpsでアクセスした際に証明書の問題のようで、「例外を追加」することでアクセス出来るようになりました。 https://support.mozilla.org/ja/kb/secure-connection-failed-error-message -------------------------------------------------------------------------------- title: "HomebrewでGUIなWiresharkをインストール" date: "2016-08-05" url: https://scribble.washo3.com/mac/homebrew-install-gui-wireshark.html -------------------------------------------------------------------------------- Mac上でWiresharkを使う仕事があったので、Homebrewでインストールしてみた。

$ brew wiresharkところが、CUIなtsharkがインストールされただけで、グラフィカルなWiresharkではありません。 GUIなWiresharkをインストールするには、オプション(引数)指定してインストール必要があるようです。 一旦、インストールしたwiresharkをアンイストールして、再インストールです。 `$ brew remove wireshark

$ brew install wireshark --with-qt

$ brew cask install wireshark-chmodbpf

$ brew linkapps wireshark` これで、/Applicationsフォルダにもリンクされたwiresharkが置かれるので、通常のアプリのようにGUIでwiresharkが起動します。 -------------------------------------------------------------------------------- title: "Mac OS Xでcronが使えない" date: "2016-07-27" url: https://scribble.washo3.com/mac/mac-osx-cron-vim.html -------------------------------------------------------------------------------- Mac OS X上でcronを使う場合、Unix/Linux同様に、下記コマンドで編集・設定が出来ます。

$ crontab -eデフォルトのエディタが起動し、編集画面となりますが、エディタがvimの場合で、保存しようとすると、下記のエラーが表示されることがあります。 > crontab: no crontab for foo – using an empty one > crontab: temp file must be edited in place どうやら、tempファイルを作成する場所に問題があるようなので、.vimrcに下記を追加

$ cat ~/.vimrc set backupskip=/tmp/*,/private/tmp/*再度、crontabで設定し、反映されていることを確認

$ crontab -lまた、デフォルトのエディタがvimでなはく、viになっている場合には下記のエラーが出ることもあります。 > crontab: no crontab for username – using an empty one crontab: “/usr/bin/vi” exited with status 1 この場合には、環境でエディタを別のエディタに指定しましょう。 vimである必要がなく、nanoでもemacsでも良いでしょう。

export EDITOR=/usr/bin/vim一時的に環境変数を変更しても良いですが、頻繁に使用するのであれば、~/.bashrcや.zshrcなどに明記しておくと良いでしょう。 -------------------------------------------------------------------------------- title: "PHP構文内でHTMLのエスケープシーケンスがエラーになる" date: "2016-06-17" url: https://scribble.washo3.com/linux/php-html-escape-error.html -------------------------------------------------------------------------------- PHP構文内にHTML記述する場合には、特殊文字はエスケープシーケンスを使う必要があります。 例えば、PHP構文内で、HTMLにてURLやパスを指定する場合

print(" <frame src=\"index.php\" name=\"head\" scrolling=\"no\">");

このように、HTML内の”は¥”で記述します。

それで、このような記述で、サーバーによって、正常に起動する場合と、エラーになる場合が発生しました。

エラーになる場合は、そのままのエスケープシーケンスが混入しているため、src=”index.php”…となるところが、src=¥”index.php¥”となっているのが原因です。

正常に動作するサーバーとエラーとなるサーバーをApache,PHPの設定で比較した所、short\_open\_tagが原因でありました。

# vim /etc/php.ini .... short_open_tag = On #<--OffからOnへ変更 ....エラーとなるサーバーでは、short\_open\_tag = Offであったため、これをOnの設定にし、Apacheを再起動したとこ、エラーが解消され、正常に動作となりました。 -------------------------------------------------------------------------------- title: "1Passwordの警告によるブラウザーの設定" date: "2016-06-17" url: https://scribble.washo3.com/mac/1password-browser-identity.html -------------------------------------------------------------------------------- しばらく前から、Google Chrome上に、Macアプリの1Password機能拡張を入れていたら、下記の警告が出るようになっていたので対処。 > **1Password can’t verify the identity of your web browser**

ヘルプを参照記事を見れば、対処方法が載っています。

https://support.1password.com/code-signature/

私の環境の場合は、Homebrew caskによるGoogle Chromeを起動していたからでした。

アプリケーションフォルダにブラウザーアプリを入れろとの事ですので、Homebrewではなく、正式にGoogle Chromeをダウンロードして、アプリケーションフォルダに入れて解決です。

尚、アプリを変更しても、タブやクッキー、機能拡張などの全ての設定は、~/Library/Application Support/Google/Chrome内に保存されていますので、安心して引き継がれます。

--------------------------------------------------------------------------------

title: "WEBページの文字化けはApacheの設定だけではなかった"

date: "2016-06-16"

url: https://scribble.washo3.com/linux/web-garbled-characters-apache.html

--------------------------------------------------------------------------------

CentOS7にて、yumでインストールしたApacheで、以前の設定のまま稼働状態になっていたにも関わらず、なぜかUTF-8以外のページが文字化けしていた。

UTF-8以外のページは、charsetの文字コードも記述しているにも関わらず、ブラウザー(Safari,Firefox,Google Chrome)で自動認識されない症状。

Apacheの設定では、このような文字化けに関する設定は、/etc/httpsd/httpsd.conf内のAddDefaultCharが関係しているので、

```

#AddDefaultCharset UTF-8

AddDefaultCharset Off

```

このどちらかを記述していれば問題ないはず。

さらには、conf.d内のバーチャルホスト等の設定も、これらの記述は書かれていないことを確認。

設定を変更したならば、Apacheを再起動することで有効になるが、これでも文字化けは解決せず。

かなり、時間を費やして、ページや設定を弄りましたが、どうやら、この問題はApacheだけではなかったようです。

**それは、PHPの設定**

PHPの設定でも、以前から全く変更はしていませんでしたが、/etc/php.ini内のdefault_charsetを空白にする必要があるようです。

```

;default_charset = "UTF-8"

default_charset = ""

```

これで、Apacheを再起動したところ、文字化けが解消されました。

文字化けしてたページ内では、ごく普通なHTMLで、PHP構文は使ってないにも関わらず、 PHPが関係していたのです。

--------------------------------------------------------------------------------

title: "SSH接続後にCan’t open display等でXが起動出来ない"

date: "2016-06-16"

url: https://scribble.washo3.com/linux/ssh-xserver-can-not-display.html

--------------------------------------------------------------------------------

sshで接続先のX Windowsを利用したGUIアプリを起動すると、よく下記のエラーなどで陥る罠

ヘルプを参照記事を見れば、対処方法が載っています。

https://support.1password.com/code-signature/

私の環境の場合は、Homebrew caskによるGoogle Chromeを起動していたからでした。

アプリケーションフォルダにブラウザーアプリを入れろとの事ですので、Homebrewではなく、正式にGoogle Chromeをダウンロードして、アプリケーションフォルダに入れて解決です。

尚、アプリを変更しても、タブやクッキー、機能拡張などの全ての設定は、~/Library/Application Support/Google/Chrome内に保存されていますので、安心して引き継がれます。

--------------------------------------------------------------------------------

title: "WEBページの文字化けはApacheの設定だけではなかった"

date: "2016-06-16"

url: https://scribble.washo3.com/linux/web-garbled-characters-apache.html

--------------------------------------------------------------------------------

CentOS7にて、yumでインストールしたApacheで、以前の設定のまま稼働状態になっていたにも関わらず、なぜかUTF-8以外のページが文字化けしていた。

UTF-8以外のページは、charsetの文字コードも記述しているにも関わらず、ブラウザー(Safari,Firefox,Google Chrome)で自動認識されない症状。

Apacheの設定では、このような文字化けに関する設定は、/etc/httpsd/httpsd.conf内のAddDefaultCharが関係しているので、

```

#AddDefaultCharset UTF-8

AddDefaultCharset Off

```

このどちらかを記述していれば問題ないはず。

さらには、conf.d内のバーチャルホスト等の設定も、これらの記述は書かれていないことを確認。

設定を変更したならば、Apacheを再起動することで有効になるが、これでも文字化けは解決せず。

かなり、時間を費やして、ページや設定を弄りましたが、どうやら、この問題はApacheだけではなかったようです。

**それは、PHPの設定**

PHPの設定でも、以前から全く変更はしていませんでしたが、/etc/php.ini内のdefault_charsetを空白にする必要があるようです。

```

;default_charset = "UTF-8"

default_charset = ""

```

これで、Apacheを再起動したところ、文字化けが解消されました。

文字化けしてたページ内では、ごく普通なHTMLで、PHP構文は使ってないにも関わらず、 PHPが関係していたのです。

--------------------------------------------------------------------------------

title: "SSH接続後にCan’t open display等でXが起動出来ない"

date: "2016-06-16"

url: https://scribble.washo3.com/linux/ssh-xserver-can-not-display.html

--------------------------------------------------------------------------------

sshで接続先のX Windowsを利用したGUIアプリを起動すると、よく下記のエラーなどで陥る罠

Error: Can't open display: unable to open X server `' unable to open display :0.0 Warning: No display specified. You will not be able to display graphics on the screen.Xの環境変数やら、ディスプレイ番号も絡んで来ると思いきや、SSH接続でX転送が有効になっていない事が多々あるのでメモ

$ ssh -Y <remote_host>接続後に、リモートホスト側のXアプリを起動。 -------------------------------------------------------------------------------- title: "CORESERVERのmysqlとmysqldumpのパス" date: "2016-05-26" url: https://scribble.washo3.com/linux/coreserver-mysql-mysqldump-path.html -------------------------------------------------------------------------------- CoreServerで動かしているWordPressでDBのバックアップが取られていない事に、今更気づいたので、確認した所、mysqlとmysqldumpが見つかりませんとの表示が出ていた。 CoreServerでは、mysqlとmysqldumpのパスが違う所にあるようなので、下記のパスに設定 > mysqldump : /usr/local/mysql/bin/mysqldump > mysql : /usr/local/mysql/bin/mysql これでOKです。 せめて、/usr/local/bin下にでも入れてくれればいいのにね。 -------------------------------------------------------------------------------- title: "Homebrewでwarning: Insecure world writableが出るようになった" date: "2016-05-26" url: https://scribble.washo3.com/mac/homebrew-warning-insecure-world-writable.html -------------------------------------------------------------------------------- ここ最近、Homebrewでまた下記のパーミッション警告が出るようになった。 > /System/Library/Frameworks/Ruby.framework/Versions/2.0/usr/lib/ruby/2.0.0/universal-darwin13/rbconfig.rb:213: warning: Insecure world writable dir /usr/local in PATH, mode 040777 下記のコマンドで警告は出なくなった。

$ sudo chown $(whoami):admin /usr/local && sudo chown -R $(whoami):admin /usr/local $ sudo chmod go-w /usr/local $ brew update-------------------------------------------------------------------------------- title: "CentOS7.xでSamba4.2が起動しない" date: "2016-05-16" url: https://scribble.washo3.com/linux/centos7-samba4-cannot-start.html -------------------------------------------------------------------------------- 職場のウェブサーバーでWindows共有が接続できないとの連絡を受け、確認したところ、Sambaが起動していなかったので、下記コマンドで起動を試みる。

# systemctl start smbすると、下記のエラーで起動しない。 > Job for smb.service failed because the control process exited with error code ### Selinuxを確認

#getenforce Disabled### Firewallを確認

# systemctl status firewalld firewalld.service - firewalld - dynamic firewall daemon Loaded: loaded (/usr/lib/systemd/system/firewalld.service; disabled; vendor preset: enabled) Active: inactive (dead)### はて?何だろう?とログを確認

# less /var/log/log.smbd ../source3/smbd/server.c:1256(main) error opening config file '/etc/samba/smb.conf'何だか、設定ファイルのsmb.confでエラーが出ている模様 なので、設定ファイルをデフォルトに戻してみた。

# cd /etc/samba # cp smb.conf smb.conf.bak # cp smb.conf.rpmnew smb.conf (私の環境だと.rpmnewになっていたが、.defaultの場合もある)### 再度、Sambaを起動

# systemctl start smb無事、起動できた。 -------------------------------------------------------------------------------- title: "CentOS7のyum updateでkernelを除外" date: "2016-04-26" url: https://scribble.washo3.com/linux/centos7-yum-exclude-kernel.html -------------------------------------------------------------------------------- CentOS7上で、yum更新した後、再起動した際に、起動できないことが度々起こりました。 具体的には、通常にyum更新をかけると、kernelのアップデートがあった場合に、アップデートされ、次回の起動時には、アップデートされたkernelで起動しますが、これが下記のエラーで止まったまま、正常に起動しないということです。 > dracut-initqueue[685]: Warning: /dev/root does not exist このエラーは今まででも何度か体験しているので、yum 更新でkernelを除外設定にした。 ### yum設定ファイルを編集

# vi /etc/yum.conf .... exclude=kernel* <--追記(サーバーとして運用しているので、xorg\*やcentos\*も実際には追記しています) ### アップデートされた場合でも、勝手に新しいkernelで起動しない設定

# vi /etc/sysconfig/kernel .... UPDATEDEFAULT=no <--yesから変更この2つの設定をしておくと、yum更新でkernelのアップデートが適用外となり、万が一、kernelアップデートされたとしても、現在のkernelで起動できるようになります。 -------------------------------------------------------------------------------- title: "QNAPをZabbixの監視対象にする" date: "2016-04-20" url: https://scribble.washo3.com/linux/qnap-monitor-zabbix.html -------------------------------------------------------------------------------- Zabbix Serverで監視対象のホストを順次登録しているのですが、NASのQNAPシリーズも監視対象にしたい。 しかし、QNAPのアプリではZabbixは存在しないので、下記の手順でインストールした。 ## QNAP CLUBからインストール (Zabbix Agent 4.x) 「[QNAPにZabbixエージェントを入れて監視する – 手当たり次第に書くんだ](https://www.si1230.com/?p=23132)」の記事通り 1. QNAPにQNAP CLUBのリポジトリを追加設定(https://www.qnapclub.eu/en/repo.xml) 2. Zabbixで検索し、Zabbix Agentをインストールし、開始を押す (開始しないとzabbixディレクトリやzabbix_agentd.confが作られない) 3. sshでQNAPへログインし、/etc/zabbix_agentd.conf内のhostとserver欄を設定 4. エージェント再起動(/etc/init.d/ZabbixAgent.sh restart) 完了したら、[Zabbix-Server側](#Zabbix-Server側)へ進んでください ## 手動インストール (Zabbix Agent 2.0.5) QNAPが古かったり、ファームウェアが古くてQNAP CLUBに対応していない場合には、下記の手動インストールを試してみてください。 ただし、エージェントのバージョンが古いです 1. Zabbixのフォーラムにて、配布されているQPKGファイルをダウンロード https://www.zabbix.com/forum/showthread.php?t=40955 2. QNAPに管理者でログインし、App Centerを開く 3. 「手動でインストール」 をクリックし、ダウンロードしたQPKGファイルを選択し、インストール 4. Zabbix _agentのインストールが完了後、起動をON 5. 次に、QNAPへTelnet若しくはSSHで管理者にてログイン 6. zabbixの設定ファイルを編集 ```# vim /etc/zabbix/zabbix_agentd.conf .... Server = xxx.xxx.xxx.xxx (Zabbix ServerのIPに設定) ``` 7. zabbix agent再起動 QNAP側で、起動しているので、一旦停止して起動させます。 ``` # /etc/init.d/zabbix_agentd.sh stop # /etc/init.d/zabbix_agentd.sh start ``` 8. zabbix agent起動確認 ``` # ps aux|grep zabbix 13738 zabbix 696 S /usr/bin/zabbix_agentd -c /etc/zabbix/zabbix_agentd.c 13743 zabbix 860 S /usr/bin/zabbix_agentd -c /etc/zabbix/zabbix_agentd.c ``` ## Zabbix Server側 1. Zabbix Serverへ管理者でログイン 2. 設定のホスト作成でQNAP用のホストを作成 IPアドレスにQNAPのIPアドレス テンプレートにTemplate OS Linux これで、しばらく待ち、エージェントの状態が緑になればOKです。 赤のまま表示されて疎通が出来ない場合は、下記を確認したほうが良いでしょう。 - ファイヤーウォールの影響 - ポートの指定、IPの指定等を確認 - Zabbix Agentの起動確認 私の失敗例として、 作業した直後、エージェントの状態が赤のままで、調べてみたら、QNAP側のzabbix agentが起動していなかったと言うオチでした。 QNAP上でzabbixを再起動した際に、横着して、zabbix_agentd.sh restartとやっちゃったんです。😉 zabix_agentd.sh stopしてstartした方が賢明かもしれません。 -------------------------------------------------------------------------------- title: "zabbix 2.4.xから3.0へアップデートしたら画面が真っ白" date: "2016-04-16" url: https://scribble.washo3.com/linux/zabbix-2to3-upgrade.html -------------------------------------------------------------------------------- 職場のzabbixを2.4.xから3.0へアップデートしたのでメモ アップデート方法は、ほぼ下記のURL通りです。(手抜き) https://qiita.com/ryouma_nagare/items/9bcf8f5e3e514103b515 違う点は、pg_dumpでなくて、mysqlを使っている点と、リポジトリの差し替えで、CentOS 6.xの環境だったので、rhelの7を6へ変更したくらいです。 まぁ、すんなりとアップデートが終わり、再起動してみた。

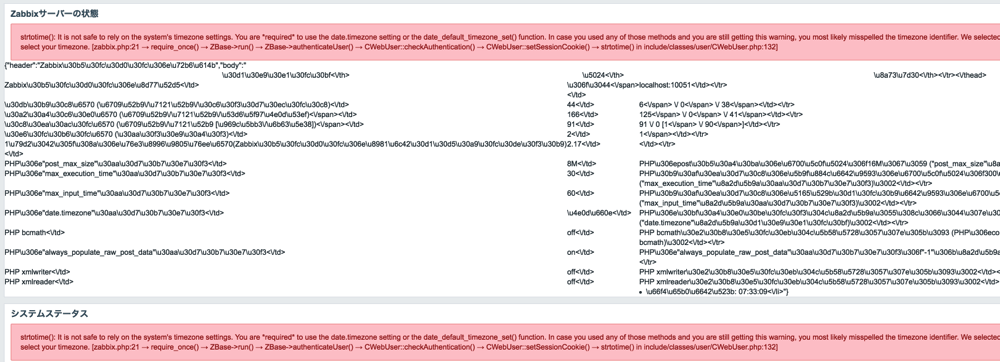

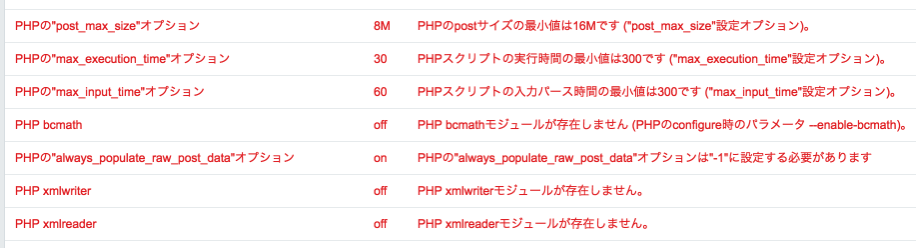

# service start zabbix-server # service start zabbix-agentそれで、いつも通りにWEBのログイン画面にアクセスすると、**画面が真っ白**! 失敗したのか、zabbixのログを見ても、表示されないエラーは見当たらず、Apacheのログを確認したところ、 > PHP Parse error: syntax error, unexpected ‘[‘ in /usr/share/zabbix/index.php on line 29 どうやら、zabbix 3.xからは、php5.6以降が必須らしい。 phpのバージョンを調べたら、5.3.xだったので、早速、phpのアップデートです。 ちなみに、php7は、まだ様子見なので、5.6.xをインストールしました。 下記URLを参考に、remiで5.6をインストールです。 https://syaka.site/2016/03/6/ phpのアップグレード完了後に、Apacheを再起動して、再度WEB画面にアクセスすると、 > Not Found The requested URL /zabbix/ was not found on this server. 2.4.xのバージョンまで、同じURLで接続出来ていたのに?と、/etc/httpsd/conf.d/zabbix.conを確認したところ、zabbix.conf.rpmsaveに名前変更されたままでしたので、zabbix.confに戻しました。 そして、再度、WEB画面にアクセス。 表示されました! が・・・何だかエラーっぽいのが沢山表示されている。

ふむ、timezoneがどうとか言ってるようで、いつの日からか、timezone設定しなきゃいけなかったのを思い出し、/etc/php.iniを編集して、timezoneを有効にした。

ふむ、timezoneがどうとか言ってるようで、いつの日からか、timezone設定しなきゃいけなかったのを思い出し、/etc/php.iniを編集して、timezoneを有効にした。

date.timezone = Asia/Tokyoさらに、Apacheを再起動して、再接続したら、エラーっぽい表示はなくなりましたが、今度は、php内のオプションを変更してね〜とな。

あとは、phpのオプション設定変更と、不足しているモジュールを導入してあげれば良いようです。

/etc/php.ini

あとは、phpのオプション設定変更と、不足しているモジュールを導入してあげれば良いようです。

/etc/php.ini

post_max_size = 16M max_execution_time = 300 max_input_time = 300 always_populate_raw_post_data = -1不足しているモジュールは、bcmathとxml関連なので、

# yum install php-bcmath php-xmlこれで、無事に正常動作が確認できました。 はぁ、疲れた。 -------------------------------------------------------------------------------- title: "rainloopでページにアクセス出来ない症状" date: "2016-04-07" url: https://scribble.washo3.com/linux/rainloop-javascript-error.html -------------------------------------------------------------------------------- 職場のWebメールをrainloopに変更したところ、ある一人から、アクセス出来ません!と報告がきた。 拝見した所、下記のエラー

Page refresh in case of javascript errorsMacのSafariの環境でエラーが出ていたので、とりあえず他のブラウザーで試してみてと提案。 Google ChromeもFirefoxも入っていなかったので、ダウンロードしようとしたところ、どちらもMac OS X 10.6以降が必須なのでダウンロード出来ませんと表示。 えっ? Mac OS Xのバージョンは? はい、10.5.xと古かったのです。 rainloopの必要要件では、対象ブラウザーが明記されているものの、バージョンまでは書かれてないようですが、恐らく、これが原因なのでしょう。 https://www.rainloop.net/docs/system-requirements/ -------------------------------------------------------------------------------- title: "homebrewのアップデートで失敗は、phinzeが原因" date: "2016-04-03" url: https://scribble.washo3.com/mac/2016-untap-homebrew-phinze.html -------------------------------------------------------------------------------- 久しぶりにbrewの更新をかけたら、下記のエラー

$ brew update ==> Tapping homebrew/core Cloning into '/usr/local/Library/Taps/homebrew/homebrew-core'... .... Error: Could not link phinze/cask manpages to: /usr/local/share/man/man1/brew-cask.1 Please delete these files and run `brew tap --repair`.どうやらphinzeは、しばらくメンテされていないようで、uptapしてあげれば良さそうです。

$ brew untap phinze/cask $ brew update; brew cleanup; brew cask cleanup-------------------------------------------------------------------------------- title: "Webmin/Usermin接続が拒否される場合" date: "2016-04-01" url: https://scribble.washo3.com/linux/webminusermin%E6%8E%A5%E7%B6%9A%E3%81%8C%E6%8B%92%E5%90%A6%E3%81%95%E3%82%8C%E3%82%8B%E5%A0%B4%E5%90%88.html -------------------------------------------------------------------------------- めったに開かないのですが、久しぶりにWebmin/Userminへアクセスしたところ、接続(アクセス)が拒否されるようになっていました。

当然、サーバーは起動しているのを確認し、Webmin/Userminの再起動も行っています。

ところが、古いブラウザでは接続出来るようなのです。

調べてみると、どうやら証明書の鍵長が1024ビット未満の場合には、アクセスが拒否するらしく、古い設定のままのWebmin/Uerminは、デフォルトで512ビットで作られているのが原因のようです。(現在のデフォルト設定は、2048になってます)

これを解決するには、証明書を再作成すると直るようですので、下記の記事を参考にしてみました。

https://www.prox.ne.jp/faq/2\_368\_ja.html

当然、サーバーは起動しているのを確認し、Webmin/Userminの再起動も行っています。

ところが、古いブラウザでは接続出来るようなのです。

調べてみると、どうやら証明書の鍵長が1024ビット未満の場合には、アクセスが拒否するらしく、古い設定のままのWebmin/Uerminは、デフォルトで512ビットで作られているのが原因のようです。(現在のデフォルト設定は、2048になってます)

これを解決するには、証明書を再作成すると直るようですので、下記の記事を参考にしてみました。

https://www.prox.ne.jp/faq/2\_368\_ja.html

なるほど、そのようにWebmin上で作成するんですね。 って、お〜〜い、そのWebmin/Usermin自体につながらないっつうの! 一番、手っ取り早いのは、Webminサーバー内の設定を一時的に変更してあげる事ではないでしょうか。

$ cd /etc/webmin/ $ vim miniserv.conf ... ssl=0 # ←1を0に変更 ... $ service webmin restartコマンドラインで作成するには、下記参照

https://d.hatena.ne.jp/kibitaki/20150718/1437231546 -------------------------------------------------------------------------------- title: "Code Sample" date: "2016-03-08" url: https://scribble.washo3.com/2016-03-08-code-sample/ -------------------------------------------------------------------------------- The following are two code samples using syntax highlighting. The following is a code sample using triple backticks ( ``` ) code fencing provided in Hugo. This is client side highlighting and does not require any special installation. ```javascript var num1, num2, sum num1 = prompt("Enter first number") num2 = prompt("Enter second number") sum = parseInt(num1) + parseInt(num2) // "+" means "add" alert("Sum = " + sum) // "+" means combine into a string ``` The following is a code sample using the "highlight" shortcode provided in Hugo. This is server side highlighting and requires Python and Pygments to be installed. {{< highlight javascript >}} var num1, num2, sum num1 = prompt("Enter first number") num2 = prompt("Enter second number") sum = parseInt(num1) + parseInt(num2) // "+" means "add" alert("Sum = " + sum) // "+" means combine into a string {{}} And here is the same code with line numbers: {{< highlight javascript "linenos=inline">}} var num1, num2, sum num1 = prompt("Enter first number") num2 = prompt("Enter second number") sum = parseInt(num1) + parseInt(num2) // "+" means "add" alert("Sum = " + sum) // "+" means combine into a string {{}} -------------------------------------------------------------------------------- title: "Subsonic 4.xから6.0betaへアップデート" date: "2016-02-24" url: https://scribble.washo3.com/linux/subsonic-4-x%E3%81%8B%E3%82%896-0beta%E3%81%B8%E3%82%A2%E3%83%83%E3%83%97%E3%83%87%E3%83%BC%E3%83%88.html --------------------------------------------------------------------------------Replace webmin self-signed certificate to avoid sec_error_invalid_key error

このサイトでも何度かSubsonicのアップデート情報を書いてますが、さほど変わりはありません。

環境は、SL6上で、Subsonic 4.xから6.0betaへのアップデートです。

たぶん、rpm -Uvhでアップデートかけても大丈夫かと思いますが、今回のアップデート作業は下記の手順で行いました。

1. Subsonicが起動していたら停止

このサイトでも何度かSubsonicのアップデート情報を書いてますが、さほど変わりはありません。

環境は、SL6上で、Subsonic 4.xから6.0betaへのアップデートです。

たぶん、rpm -Uvhでアップデートかけても大丈夫かと思いますが、今回のアップデート作業は下記の手順で行いました。

1. Subsonicが起動していたら停止

# service subsonic stop2. javaのインストール

# sudo yum install java-1.7.0-openjdk3. 最新版をダウンロード (https://www.subsonic.org/pages/download.jsp)でrpmをダウンロード 4. アップデート

# sudo yum install --nogpgcheck subsonic-x.x.rpmもし、アップデートが上手くいかなければ、古いパッケージを削除してからインストールしましょう。

# sudo yum remove subsonicバージョンアップ後は、4.xからの設定等もそのまま引き継がれました。 5.xのバージョンをすっ飛ばしてのバージョンアップなので、結構UIが洗練されてますね。 6.0betaではHTML5Audioが採用されていますが、やっぱりiPhone/iPadのブラウザ上での再生はダメか。 また、DLNAを有効にしても、我が家のムービーファイルは再生出来なかった。(T_T) -------------------------------------------------------------------------------- title: "Macのディスクユーティリティでマウント解除できない時の対処" date: "2015-08-19" url: https://scribble.washo3.com/mac/mac-diskutility-cannot-unmount.html -------------------------------------------------------------------------------- 私の使っているiMac内蔵のSSDがよく壊れます。 ディスクユーティリティで検証・修復しようとしても、`修復できません`との警告で、よく復旧作業を行うことがあります。 通常だと、「⌘(コマンド)+ R」のリカバリモードで起動し、ディスクユーティリティを起動して、壊れたSSD/HDDを消去するのですが、時々、`マウント解除できませんでした`と消去すらできない症状に遭遇します。 おそらく、リカバリーモードで起動しても、消去対象のSSD/HDDに何らかのアクセスがあるからマウント解除できないのでしょう。 ## USB起動ディスクを作成して解決 ディスクユーティリティを抜け、コンソールで調べてみても良いかと思いますが、面倒臭いので、USBディスクで起動するとあっさり消去できますので、緊急起動用にインストールUSBを作成しておくと良いです。 ちょっと情報古いですが、インストールUSBの作り方はこんな感じで↓ また、Apple公式サイトでも、最新のOSまで対応した作成手順が公開されてますので、ごちらも参考になるかと思います。 ## ターミナル(コンソール)で解決 コンソールで作業したい方は、psやlsofで消去対象のSSD/HDDを探して、プロセスを殺すと上手く行くかと思います。 ```bash $ sudo lsof /Volumes/<HDD名や共有名> mds 60 root 50r DIR 48,12 16384 2 /Volumes/share Finder 360 hoge 26r DIR 48,12 16384 2 /Volumes/share zsh 75882 hoge cwd DIR 49,10 1554 2 /Volumes/share ``` この場合は、shareのディレクトリがFinderとzshで利用されているので、Finderで開いていないか、またはコンソール(zsh)でshare内に入ったままになっていないか確認すればOKですね。 偶に、Finderが全て閉じているにも関わらず、アンマウントできないことがあるので、その場合には、Finderを`Option+右クリック`で「再度開く」により、Finderを再起動しましょう。 -------------------------------------------------------------------------------- title: "3日間悩んだApache2.4系ユーザーディレクトリのForbidden" date: "2015-08-18" url: https://scribble.washo3.com/linux/apache2-4-userdir-forbidden.html -------------------------------------------------------------------------------- Apache2.4系を入れる必要があったので、CentOS6/Apache2.2からCentOS7/Apache2.4へ更新しました。 2.4系では、httpsd.conf内の書式やアクセス制御の書式も変更になり、修正を施し、Apache起動まで確認できたところで、ユーザーディレクトリの設定を有効にしたところ、Fobiddenのエラーでハマってしまいました。 この時の環境では、 * Firewall無効 * SELinux無効 * mod_userdir.soのモジュールが読み込まれているか確認 * /etc/httpsd/conf.d/userdir.con内を確認 UserDir public_html

<Directory "/home/*/*/public_html"> AllowOverride ALL Options IncludesNoExec ExecCGI FollowSymLinks Require method GET POST OPTIONS </Directory>これで、Apacheを再起動したところ、チルダ(~)による各ユーザーのホームページが閲覧できるようになった。 結果オーライだが、/home/\*/\*/public_htmlの書式は、何かスマートじゃないよね? 何かよい書き方もしくは方法があったら、教えてください。 -------------------------------------------------------------------------------- title: "CentOS7でネットワーク不調だった原因" date: "2015-08-17" url: https://scribble.washo3.com/linux/centos7%E3%81%A7%E3%83%8D%E3%83%83%E3%83%88%E3%83%AF%E3%83%BC%E3%82%AF%E4%B8%8D%E8%AA%BF%E3%81%A0%E3%81%A3%E3%81%9F%E5%8E%9F%E5%9B%A0.html -------------------------------------------------------------------------------- CentOS7をインストール後に、nfsに接続できなかったり、digでDNS情報が引けなかったりと、四苦八苦してました。 NFSでは、下記の環境 * Firewall無効 * SELinux無効 * NFS関連のプログラムはインストール済み * 関連プログラムは、起動済み * tcp_wrapperrrで制限はしていない * Google等へのpingでネットワーク疎通確認 * autofsも起動している autofsで指定しているフォルダにアクセスしても、手動でmountコマンドを打っても、しばらく経ったあとに、Connection timed out.で接続できない。 また、接続先を変更してみても、接続できないので、サーバー側で弾かれているわけではなさそう。 ググってみると、状況によっては、IPアドレスと名前のマッピングも関係する場合があるとの情報もあったので、hostsやDNS関連も確認した。 この作業の途中で、DNSのdigコマンドで自分のホストを確認しようとしてみたところ、なぜかdigの情報がGoogle等では引けるのに、自分のDNSでは引けないことに気づく。 なぜ?と、徐ろに、ipコマンドを打ってみた。

# ip addr 2: ens32: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000 link/ether 00:0cxx:b0:xx:e0 brd ff:ff:ff:ff:ff:ff inet 192.168.1.37/32 brd 192.168.1.37 scope global ens32もう、お分かりになったでしょう! サブネットマスクが32になっているではありませんか。 CentOS7のネットワーク設定で、nmtuiコマンドによりネットワーク設定を行ったわけですが、IPアドレス入力欄で192.168.1.37だけを入力した時に、自動的に192.168.1.37/32へ設定されていたようでした。 もう一度、nmtuiを起動して変更しても構いませんが、下記を編集して手動で対処した。

# vi /etc/sysconfig/network-scripts/ifcfg-en32 PREFIX=24 #32から24へ変更して保存 # systemctl restart networkこれにて、NFSもdigも一件落着しました。 -------------------------------------------------------------------------------- title: "Error: uninitialized constant Formulary::HOMEBREW_CORE_FORMULA_REGEX" date: "2015-08-13" url: https://scribble.washo3.com/mac/error-uninitialized-constant-formularyhomebrew_core_formula_regex.html -------------------------------------------------------------------------------- MacのHomebrewでアップデートをかけると、またもや下記のエラー Error: uninitialized constant Formulary::HOMEBREW\_CORE\_FORMULA_REGEX >

$ brew update

Error: uninitialized constant Formulary::HOMEBREW_CORE_FORMULA_REGEX

Please report this bug:

https://git.io/brew-troubleshooting

/usr/local/Library/Homebrew/formulary.rb:227:in `loader_for'

/usr/local/Library/Homebrew/formulary.rb:176:in `factory'

/usr/local/Library/Homebrew/cmd/update.rb:173:in `block in report'

/usr/local/Library/Homebrew/cmd/update.rb:159:in `each_line'

/usr/local/Library/Homebrew/cmd/update.rb:159:in `report'

/usr/local/Library/Homebrew/cmd/update.rb:24:in `update'

/usr/local/Library/brew.rb:140:in `<main>'

gitのトラブルシューティングを見ろとの事で、https://github.com/Homebrew/homebrew/issues/42553に書いてありました。

もう一度、brew updateをかければ良いみたいです。

$ brew --version 0.9.5 $ brew update Already up-to-date.-------------------------------------------------------------------------------- title: "Debian 8(Jessie)にVMware Toolsをインストール" date: "2015-04-28" url: https://scribble.washo3.com/linux/debian-8jessie%E3%81%ABvmware-tools%E3%82%92%E3%82%A4%E3%83%B3%E3%82%B9%E3%83%88%E3%83%BC%E3%83%AB.html -------------------------------------------------------------------------------- 前記で、Debian 8(Jessie)をVMware Fusion上にインストールしたので、VMware-Toolsを導入しました。 まずは、VMwareTools導入にあたり、必須となるファイルやプログラムをDebian上にインストールします。 ``` # apt-get install gcc make perl

# apt-get install linux-headers-$(uname -r)` ``` MacのVMware Fusion上のメニュー欄から仮想マシンのVMware Toolsのインストール選びます。 すると、/media/cdromへマウントされます。 その中の既存のインストーラを起動しようとすると・・下記のエラー > chmod: \`./vmware-tools-upgrader-64′ のパーミッションを変更しています: 読み込み専用ファイルシステムです なので、/tmp/に展開してインストール ``` # tar zxf /media/cdrom/VMwareTools-9.9.2-2496486.tar.gz -C /tmp

# cd tmp/mware-tools-distrib/

# ./vmware-install.pl` ``` 再起動後、VMwareToolsが有効になっている事と思います。 -------------------------------------------------------------------------------- title: "Debian wheezy(7.8) から jessie(8.0)へアップグレード" date: "2015-04-28" url: https://scribble.washo3.com/linux/debian-wheezy7-8-%E3%81%8B%E3%82%89-jessie8-0%E3%81%B8%E3%82%A2%E3%83%83%E3%83%97%E3%82%B0%E3%83%AC%E3%83%BC%E3%83%89.html -------------------------------------------------------------------------------- Debianが約2年ぶりにメジャーアップグレードで、[Debian 8.0 Jessie][1]がリリースされましたので、早速、既存の7.x(wheezy)からアップグレードを行ってみました。 メジャーアップグレードでリリースされたばかりなので、用心をとって、VMware Fusion上にてテスト的にアップグレードです。

VMware Fusion上で、7.8(wheezy)をnet installした後、8.0(jessie)へのアップグレード方法です。

もし、運用しているwheezyをそのままアップグレードする場合には、/etc下やapt関連のバックアップを取ってから行った方が良いでしょう。

1. 既存のパッケージを更新しておきます。

`# apt-get update; apt-get upgrade`

また、整合性の競合がないことも確認しておきましょう

2. wheezyからjessieへsourcelessを変更

`# sed -i 's/wheezy/jessie/g' /etc/apt/sources.list`

3. 更新・アップグレード

```

# apt-get update

# apt-get upgrade

# apt-get dis-upgrade

```

4. 掃除

`# aptitude purge '~c’`

5. 再起動

`# init 6`

6. バージョン確認

```

# lsb_release -aNo LSB modules are available.

Distributor ID: Debian

Description: Debian GNU/Linux 8.0 (jessie)

Release: 8.0

Codename: jessie

```

以上で、7.xから8へのアップグレード完了です。

jessieから、GNOMEが標準になったり、標準のinitシステムがSysVinitからSystemdへ変更されたりと、7.xとは大幅な変更がありますし、リリースされたばかりと言うこともあり、不具合も出る可能性が大いにあるので、急がなければ、1ヶ月近くは様子をみて、アップグレードした方が良いかと思われます。

[1]: https://www.debian.or.jp/using/index.html

--------------------------------------------------------------------------------

title: "Scientifix Linux 6.4から6.6へアップグレード"

date: "2015-04-27"

url: https://scribble.washo3.com/linux/scientifix-linux-6-4%E3%81%8B%E3%82%896-6%E3%81%B8%E3%82%A2%E3%83%83%E3%83%97%E3%82%B0%E3%83%AC%E3%83%BC%E3%83%89.html

--------------------------------------------------------------------------------

ここのサーバで稼働しているScientific Linux 6 (SL6)を、バージョン6.4で止まったままでしたので、最新(現時点で6.6)へアップグレードしました。

一応、バージョン確認

`$cat /etc/redhat-release

VMware Fusion上で、7.8(wheezy)をnet installした後、8.0(jessie)へのアップグレード方法です。

もし、運用しているwheezyをそのままアップグレードする場合には、/etc下やapt関連のバックアップを取ってから行った方が良いでしょう。

1. 既存のパッケージを更新しておきます。

`# apt-get update; apt-get upgrade`

また、整合性の競合がないことも確認しておきましょう

2. wheezyからjessieへsourcelessを変更

`# sed -i 's/wheezy/jessie/g' /etc/apt/sources.list`

3. 更新・アップグレード

```

# apt-get update

# apt-get upgrade

# apt-get dis-upgrade

```

4. 掃除

`# aptitude purge '~c’`

5. 再起動

`# init 6`

6. バージョン確認

```

# lsb_release -aNo LSB modules are available.

Distributor ID: Debian

Description: Debian GNU/Linux 8.0 (jessie)

Release: 8.0

Codename: jessie

```

以上で、7.xから8へのアップグレード完了です。

jessieから、GNOMEが標準になったり、標準のinitシステムがSysVinitからSystemdへ変更されたりと、7.xとは大幅な変更がありますし、リリースされたばかりと言うこともあり、不具合も出る可能性が大いにあるので、急がなければ、1ヶ月近くは様子をみて、アップグレードした方が良いかと思われます。

[1]: https://www.debian.or.jp/using/index.html

--------------------------------------------------------------------------------

title: "Scientifix Linux 6.4から6.6へアップグレード"

date: "2015-04-27"

url: https://scribble.washo3.com/linux/scientifix-linux-6-4%E3%81%8B%E3%82%896-6%E3%81%B8%E3%82%A2%E3%83%83%E3%83%97%E3%82%B0%E3%83%AC%E3%83%BC%E3%83%89.html

--------------------------------------------------------------------------------

ここのサーバで稼働しているScientific Linux 6 (SL6)を、バージョン6.4で止まったままでしたので、最新(現時点で6.6)へアップグレードしました。

一応、バージョン確認

`$cat /etc/redhat-releaseScientific Linux release 6.4 (Carbon)` 普通にyum updateしても、最新へアップグレードされないままでしたので、下記コマンドで無事6.6へアップグレード。 `# yum install -y yum-conf-sl6x

# yum clean all

# yum update` アップグレード後、再起動して確認 `$ cat /etc/redhat-release

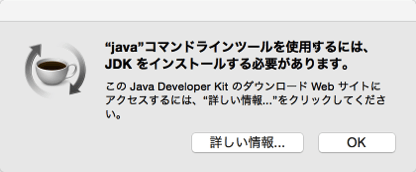

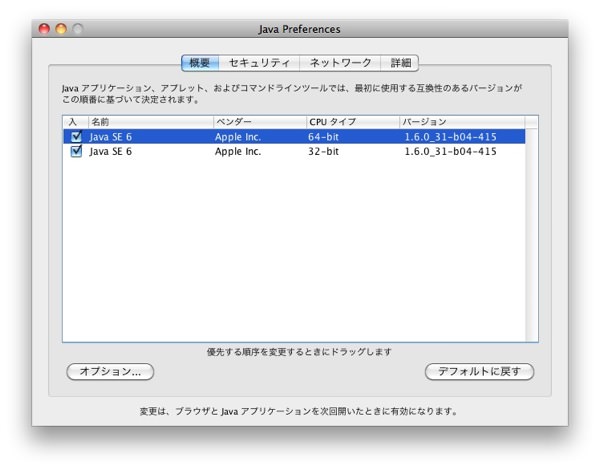

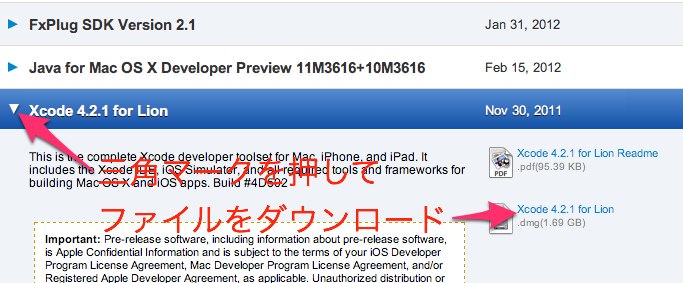

Scientific Linux release 6.6 (Carbon)` -------------------------------------------------------------------------------- title: "Macでjavaのjarファイルを実行" date: "2015-04-02" url: https://scribble.washo3.com/mac/mac%E3%81%A7java%E3%81%AEjar%E3%83%95%E3%82%A1%E3%82%A4%E3%83%AB%E3%82%92%E5%AE%9F%E8%A1%8C.html -------------------------------------------------------------------------------- 時々、Mac上のターミナルで、Javaのjarファイルを実行したい時があるのでメモ。 javaの起動には、Java Developer Kitが必須のようなので、下記のアドレスからMac版をダウンロードして、インストールしておく。

[Java SE Development Kit 8 - Downloads](https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html)

執筆時点だとjdk-8u241-macosx-x64.dmg

その後に、下記コマンドで実行

```

$ java -jar jarfile.jar

```

--------------------------------------------------------------------------------

title: "複製したVMwareゲストOSがネットワークにつながらない時に確認するポイント"

date: "2015-04-02"

url: https://scribble.washo3.com/network/%E8%A4%87%E8%A3%BD%E3%81%97%E3%81%9Fvmware%E3%82%B2%E3%82%B9%E3%83%88os%E3%81%8C%E3%83%8D%E3%83%83%E3%83%88%E3%83%AF%E3%83%BC%E3%82%AF%E3%81%AB%E3%81%A4%E3%81%AA%E3%81%8C%E3%82%89%E3%81%AA%E3%81%84.html

--------------------------------------------------------------------------------

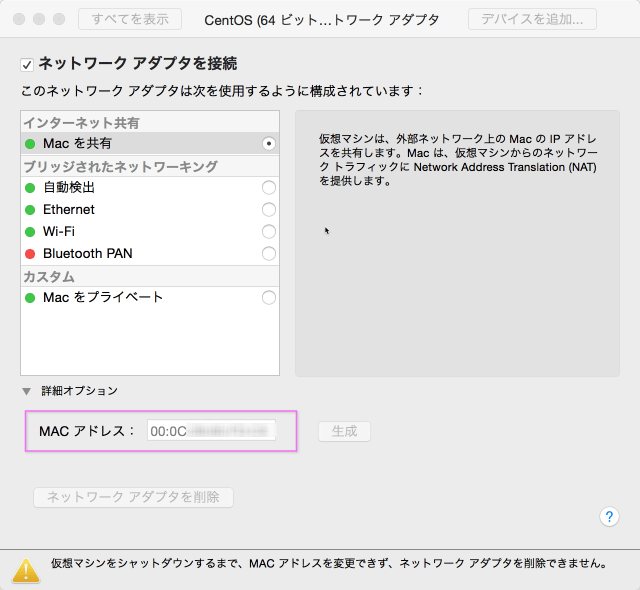

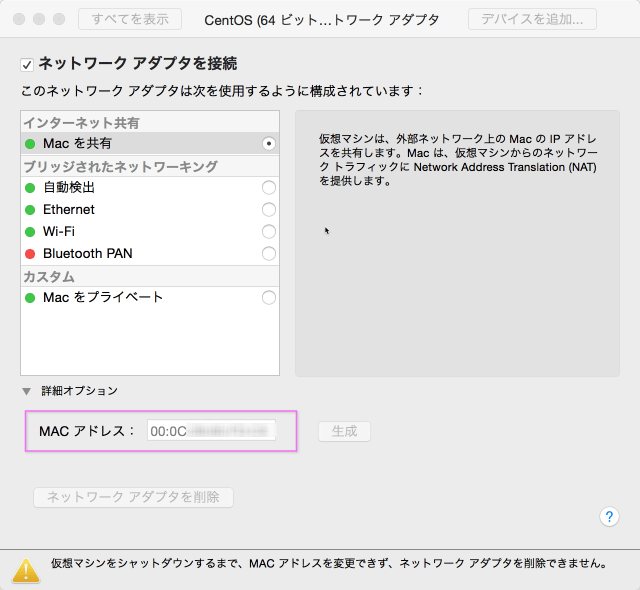

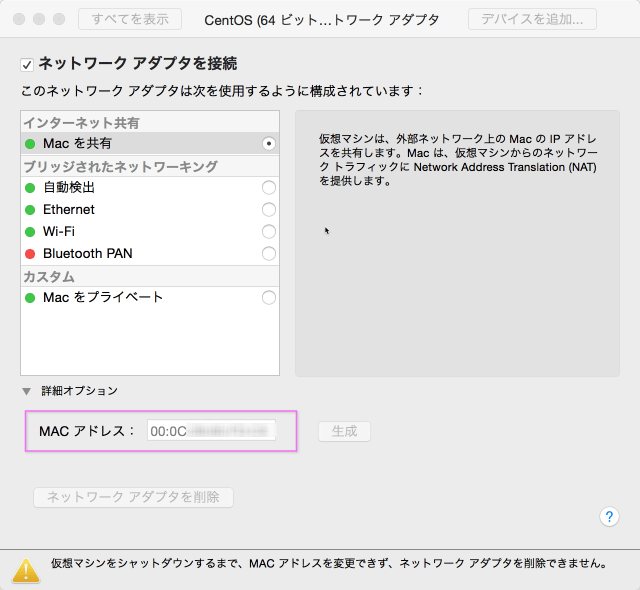

VMware Fusionで他からコピーしてきたCentOSのゲストOSをそのまま起動しようとすると、デバイス名(eth*)が認識されなくてネットワークが利用できません。ちなみにVirtualBoxでも同様だと思います。

`# ifconfig -a`

loしか表示されず、eth*が表示されない

ここでのポイントは、MACアドレスとデバイス名を確認し、修正する事で、おおよそ解決できるかと思います。

## MACアドレスの確認と修正

### 確認

ゲストOSのCentOSを起動後、ログインし、/etc/sysconfig/network-scripts/ifcfg-eth0(←この数字は環境に合わせて)を確認します。

```

# cat /etc/sysconfig/network-scripts/ifcfg-eth0`

```

ここで表示されたHWADDRのMACアドレスを確認します

次に、VMware Fusion上の起動したCentOSの設定より、ネットワークアダプターを選び、下部の詳細オプションをクリックします。

[Java SE Development Kit 8 - Downloads](https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html)

執筆時点だとjdk-8u241-macosx-x64.dmg

その後に、下記コマンドで実行

```

$ java -jar jarfile.jar

```

--------------------------------------------------------------------------------

title: "複製したVMwareゲストOSがネットワークにつながらない時に確認するポイント"

date: "2015-04-02"

url: https://scribble.washo3.com/network/%E8%A4%87%E8%A3%BD%E3%81%97%E3%81%9Fvmware%E3%82%B2%E3%82%B9%E3%83%88os%E3%81%8C%E3%83%8D%E3%83%83%E3%83%88%E3%83%AF%E3%83%BC%E3%82%AF%E3%81%AB%E3%81%A4%E3%81%AA%E3%81%8C%E3%82%89%E3%81%AA%E3%81%84.html

--------------------------------------------------------------------------------

VMware Fusionで他からコピーしてきたCentOSのゲストOSをそのまま起動しようとすると、デバイス名(eth*)が認識されなくてネットワークが利用できません。ちなみにVirtualBoxでも同様だと思います。

`# ifconfig -a`

loしか表示されず、eth*が表示されない

ここでのポイントは、MACアドレスとデバイス名を確認し、修正する事で、おおよそ解決できるかと思います。

## MACアドレスの確認と修正

### 確認

ゲストOSのCentOSを起動後、ログインし、/etc/sysconfig/network-scripts/ifcfg-eth0(←この数字は環境に合わせて)を確認します。

```

# cat /etc/sysconfig/network-scripts/ifcfg-eth0`

```

ここで表示されたHWADDRのMACアドレスを確認します

次に、VMware Fusion上の起動したCentOSの設定より、ネットワークアダプターを選び、下部の詳細オプションをクリックします。

表示されたMACアドレスが新しいものなので、ifcfg-eth0内のMACアドレスをこれに置き換えます。

保存後に、ネットワークを有効化します。

```

# /sbin/service network start

```

この後に、何もエラーが出ずに、ネットワークが利用できるのであれば、これだけで終了です。

しかし、ほとんどが、下記のエラーが出る場合が多いです。

> Device eth0 does not seem to be present, delaying initialization

## デバイス名の設定変更

```

# cat /etc/udev/rules.d/70-persistent-net.rules

# `PCI device 0x8086:0x100f (e1000)

SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*", ATTR{address}=="00:0c:29:92:xx:xx", ATTR{type}=="1", KERNEL=="eth*", NAME="eth0"

表示されたMACアドレスが新しいものなので、ifcfg-eth0内のMACアドレスをこれに置き換えます。

保存後に、ネットワークを有効化します。

```

# /sbin/service network start

```

この後に、何もエラーが出ずに、ネットワークが利用できるのであれば、これだけで終了です。

しかし、ほとんどが、下記のエラーが出る場合が多いです。

> Device eth0 does not seem to be present, delaying initialization

## デバイス名の設定変更

```

# cat /etc/udev/rules.d/70-persistent-net.rules

# `PCI device 0x8086:0x100f (e1000)

SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*", ATTR{address}=="00:0c:29:92:xx:xx", ATTR{type}=="1", KERNEL=="eth*", NAME="eth0"

# PCI device 0x8086:0x100f (e1000) SUBSYSTEM=="net", ACTION=="add", DRIVERS=="?*", ATTR{address}=="00:0c:29:65:yy:yy", ATTR{type}=="1", KERNEL=="eth*", NAME="eth1" ` ``` 同じネットワークデバイス名が存在し、上記が古いMACアドレス、下記が新しいMACアドレスになっているかと思います。 下記のMACアドレスが、上図の詳細オプションで表示されたMACアドレスになっていることを確認し、上記の古い情報(デバイス、MACアドレス)を削除します。 このままでも問題はありませんが、ネットワークデバイス名がeth0でなく、eth1となってしまうので、eth1をeth0に変更すると良いでしょう。 この後、OS再起動するとネットワークが利用できる環境になっている事と思います。 -------------------------------------------------------------------------------- title: "Test markdown" date: "2015-02-20" url: https://scribble.washo3.com/2015-02-20-test-markdown/ -------------------------------------------------------------------------------- You can write regular [markdown](http://markdowntutorial.com/) here and Jekyll will automatically convert it to a nice webpage. I strongly encourage you to [take 5 minutes to learn how to write in markdown](http://markdowntutorial.com/) - it'll teach you how to transform regular text into bold/italics/headings/tables/etc. **Here is some bold text** ## Here is a secondary heading Here's a useless table: | Number | Next number | Previous number | | :------ |:--- | :--- | | Five | Six | Four | | Ten | Eleven | Nine | | Seven | Eight | Six | | Two | Three | One | How about a yummy crepe?  Here's a code chunk with syntax highlighting: ```javascript var foo = function(x) { return(x + 5); } foo(3) ``` -------------------------------------------------------------------------------- title: "コマンドラインで Macのバージョン確認" date: "2015-02-05" url: https://scribble.washo3.com/mac/%E3%82%B3%E3%83%9E%E3%83%B3%E3%83%89%E3%83%A9%E3%82%A4%E3%83%B3%E3%81%A7-mac%E3%81%AE%E3%83%90%E3%83%BC%E3%82%B8%E3%83%A7%E3%83%B3%E7%A2%BA%E8%AA%8D.html -------------------------------------------------------------------------------- 普通にMacを目の前にして、GUIにてMacのバージョンを確認するには、アップルメニューから「このMacについて」を選択するだけですけど、SSHで遠隔ログインしている時に、あれ?バージョン確認ってどうやるんだろうと思ったのでメモ。 ターミナルから、sw_versと打つだけ。